※ 25년 신규 개방되는 데이터로, 데이터 활용성 검토, 이용자 관점의 개선의견 수렴 등을 통해 수정/보완될 수 있으며 최종데이터, 샘플데이터, 산출물 등은 변경될 수 있습니다.

-

데이터 변경이력

데이터 변경이력 버전 일자 변경내용 비고 1.0 2025-04-16 데이터 개방 Beta Version 데이터 히스토리

데이터 히스토리 일자 변경내용 비고 2025-04-16 산출물 전체 공개 소개

글쓰기 자동 평가 및 피드백 모델 개발을 위한 데이터 구축을 통해 교육 개혁에 따른 창의력 및 문제해결력 중심의 평가 혁신을 위한 서술형 평가의 효율적 수행 기반 체계 확보

구축목적

ㅇ 자동화된 평가 및 피드백 서비스 제공 ㅇ 맞춤형 학습 플랫폼 개발 및 서비스

-

메타데이터 구조표 데이터 영역 교육 데이터 유형 텍스트 데이터 형식 txt 데이터 출처 자체수집 라벨링 유형 글쓰기 채점, 피드백 라벨링 형식 json 데이터 활용 서비스 글쓰기 자동 평가 및 피드백 할 수 있는 기술개발에 활용 데이터 구축년도/

데이터 구축량2024년/ㅇ 원천데이터 40,000건 14-025 서술형 글쓰기 평가 40,000건 ㅇ 라벨링 데이터 40,000건 14-025 서술형 글쓰기 평가 40,000건 -

▶ 데이터 구축 규모

데이터 구축 규모 데이터명 RFP 제시량 원천데이터 수량 라벨링 데이터

수량RFP

대비14-025 서술형글쓰기 - 학년별/주제별 서술형 글쓰기 데이터 2만 건 이상

- 2인이상의 전문가가 평가한 데이터 2만건 이상- 글쓰기 데이터 40,000건

- 평가데이터 80,000건

- 피드백데이터 40,000건40,000건 200% ▶ 데이터 분포

-학년(나이)별 데이터 수와 작성자 비율데이터 분포-학년(나이)별 데이터 수와 작성자 비율 구분 학년(나이) 데이터 수 비중 14-025 서술형 글쓰기 초등 초5 10,000 25.00% 초6 10,000 25.00% 소계 20,000 50.00% 중등 중1 7,000 17.50% 중2 7,000 17.50% 중3 6,000 15.00% 소계 20,000 50.00% 총계 40,000 100.00% - 교과 주제별 난이도별 수량

교과 주제별 난이도별 수량 데이터셋 학년 교과주제 난이도 합계 상 중 하 14-025 서술형 글쓰기 초등학생 5학년 국어 1,000 1,000 1,000 3,000 사회 1,000 1,000 1,000 3,000 과학 750 750 700 2,200 수학 600 600 600 1,800 6학년 국어 1,000 1,000 1,000 3,000 사회 1,000 1,000 1,000 3,000 과학 750 750 700 2,200 수학 600 600 600 1,800 소계 6,700 6,700 6,600 20,000 중학생 1학년 국어 700 700 700 2,100 사회 700 700 700 2,100 과학 550 550 550 1,650 수학 400 400 350 1,150 2학년 국어 700 700 700 2,100 사회 700 700 700 2,100 과학 550 550 550 1,650 수학 400 400 350 1,150 3학년 국어 600 600 600 1,800 사회 600 600 600 1,800 과학 500 500 500 1,500 수학 300 300 300 900 소계 6,700 6,700 6,600 20,000 계 13,400 13,400 13,200 40,000 -

-

AI 모델 상세 설명서 다운로드

AI 모델 상세 설명서 다운로드 AI 모델 다운로드▶ AI학습모델 개요

AI학습모델 개요 AI모델 task AI모델 성능 지표 및 목표값 Data I/O 채점 평가 Llama 3.1 f1 score 0.6 Input data : 질문, 답변, 평가지표 output data : 평가점수

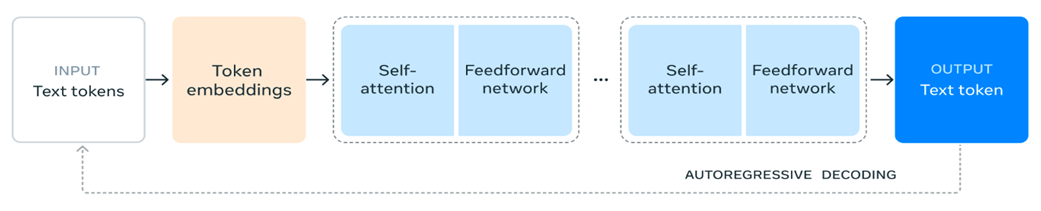

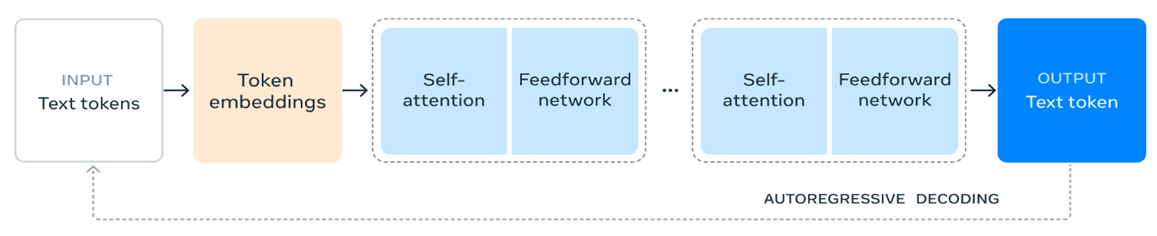

- Llama 3.1은 Llama 계열 중 최근에 발표된 모델로 오픈소스 모델이며 좋은 성능을 보여주고 있습니다. - Llama 3.1은 표준 디코더 전용 트랜스포머 모델을 기반으로 하되, 학습 안정성을 극대화하기 위해 일부 수정을 가했습니다. 특히 전문가 혼합(Mixture of Experts) 모델 대신 단일 모델 구조를 채택하여 학습의 안정성을 높였습니다. - 사전 학습 및 후처리 과정에서 데이터의 양과 질을 모두 개선했습니다. 더 신중한 전처리 파이프라인과 엄격한 품질 보증 과정을 거쳐 고품질의 데이터만을 사용했습니다. - 지도 학습 미세 조정(Supervised Fine-Tuning)과 직접 선호도 최적화(Direct Preference Optimization)를 반복적으로 적용하는 후처리 기법을 도입했습니다. 이를 통해 각 능력의 성능을 점진적으로 향상시켰습니다. - 해당 모델의 인코더만을 사용한 후 뒤에 헤더를 붙여 채점 모델로 사용합니다. AI모델 task AI모델 성능 지표 및 목표값 Data I/O 피드백 생성 Llama 3.1 Perplexity 학습 전후 10%이상감소 Input data : 질문, 답변, 평가지표 output data : 피드백

- Llama 3.1은 Llama 계열 중 최근에 발표된 모델로 오픈소스 모델이며 좋은 성능을 보여주고 있습니다. - Llama 3.1은 표준 디코더 전용 트랜스포머 모델을 기반으로 하되, 학습 안정성을 극대화하기 위해 일부 수정을 가했습니다. 특히 전문가 혼합(Mixture of Experts) 모델 대신 단일 모델 구조를 채택하여 학습의 안정성을 높였습니다. - 사전 학습 및 후처리 과정에서 데이터의 양과 질을 모두 개선했습니다. 더 신중한 전처리 파이프라인과 엄격한 품질 보증 과정을 거쳐 고품질의 데이터만을 사용했습니다. - 지도 학습 미세 조정(Supervised Fine-Tuning)과 직접 선호도 최적화(Direct Preference Optimization)를 반복적으로 적용하는 후처리 기법을 도입했습니다. 이를 통해 각 능력의 성능을 점진적으로 향상시켰습니다. - 해당 모델의 디코더를 이용하여 피드백 생성을 진행합니다. ▶ AI모델 평가 결과 지표

AI모델 평가 결과 지표 클래스 구분 평가지표 목표 검증 결과 14-025 서술형글쓰기 채점 평가 f1 score 0.6 이상 0.94 / 달성 피드백 생성 perplexity 학습 전후 10% 이상 감소 24.08% 감소 / 달성 ▶ 유효성 검증 모델의 학습 미 검증 조건

유효성 검증 모델의 학습 미 검증 조건 유효성 검증 모델 학습 및 검증 조건 CPU Intel® Xeon® Gold 6226R Processor Memory 256GB GPU NVIDIA A100 80GB PCIe * 2 Storage 1TB OS Ubuntu 20.04 개발언어 Python 3.8.10 프레임워크 CUDA 12.2, Pytorch 2.5.1 학습알고리즘 transformer 학습조건 epoch = 60, batch_size = 1, optimizer = AdamW 파일 형식 원천 데이터셋 텍스트 (CSV) 라벨링 데이터셋 텍스트 (JSON) 전체 구축 데이터 대비

모델에 적용 비율

14-025 서술형 글쓰기 평가 데이터 총 수량: 40,006건 (100%) 모델 학습 과정별

데이터 분류 및 비율 정보

14-025 서술형 글쓰기 평가 데이터 - Training Set: 32,006건 (80%) - Validation Set: 4,000건 (10%) - Test Set: 4,000건 (10%) -

설명서 및 활용가이드 다운로드

데이터 설명서 다운로드 구축활용가이드 다운로드▶ 데이터 구성

데이터 구성 구분 획득/수집 단계 정제 단계 가공 단계 데이터 구분 원시데이터 원천데이터 라벨링데이터 데이터 형태 이미지 파일,TXT파일 CSV JSON ▶ 어노테이션 포맷

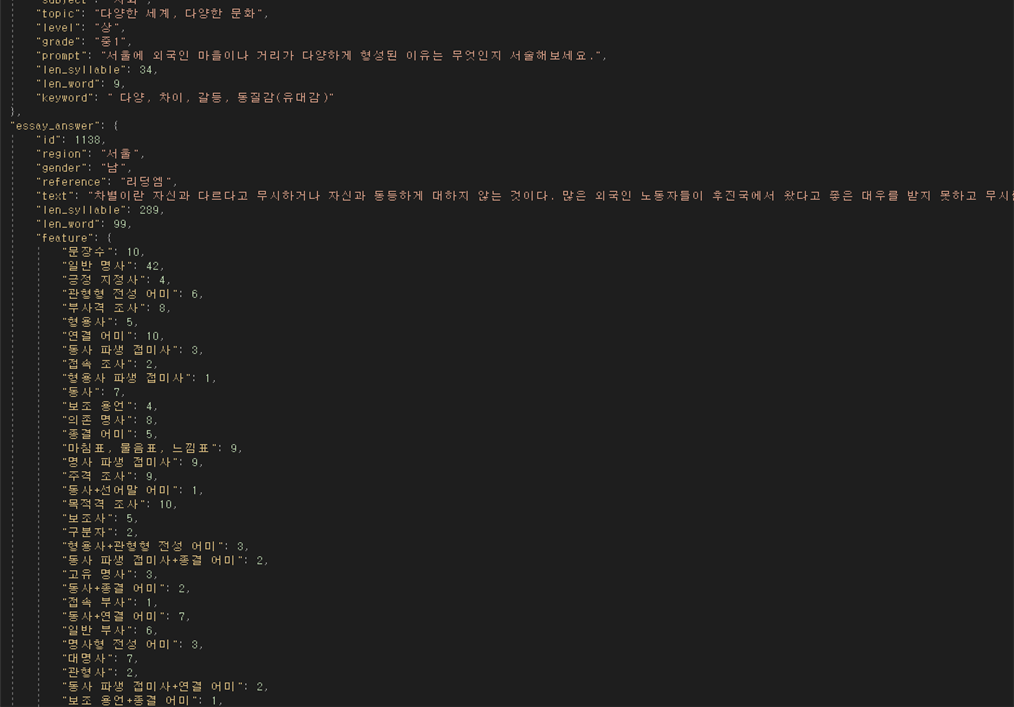

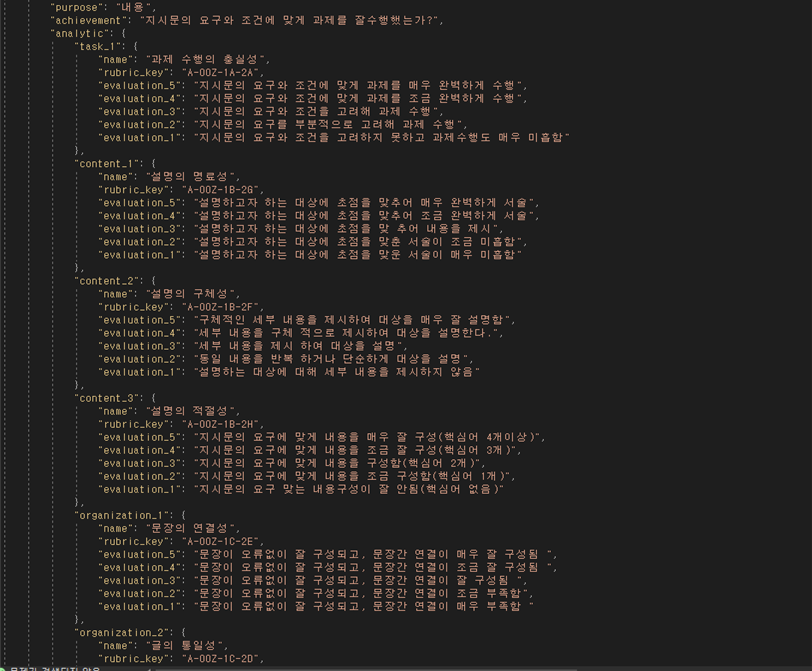

14-025 서술형 글쓰기 평가 데이터어노테이션 포맷-색상표기 색상 표기 내용 AI 학습용 입력 데이터 정량 평가용 AI 학습 정답 데이터 정성 평가용 AI 학습 정답 데이터 메타 데이터 어노테이션 포맷 구분 속성명 타입 필수여부 설명 범위 비고 1 essay_question object Y 에세이 지시문 정보 - 1.1 id string Y 지시문의 아이디 A01 1.2 type string Y 지시문의 유형 서술형 글쓰기 1.3 subject string Y 과목 국어, 사회, 과학, 수학 1.4 topic string Y 에세이의 주제 우리말지킴이... 1.5 level string Y 지시문의 난이도 상, 중, 하 1.6 grade string Y 대상 학년 초5, 초6, 중1, 중2, 중3 1.7 prompt string Y 지시문 우리말을 바르게 ... 1.8 len_syllable int Y 지시문의 음절수 143 1.9 len_word int Y 지시문의 어절수 36 1.1 keyword string Y 지시문의 키워드 [구성원, 존중, ...] 2 essay_answer object Y 에세이 답변 정보 - 2.1 id string Y 답변 아이디 S01 2.2 region string Y 지역 경기도 수원시... 2.3 gender string Y 답변자 성별 남, 여 2.4 reference string Y 답변 수집 출처 온라인 경진대회 2.5 text string Y 답변 야민정음은... 2.6 len_syllable int Y 답변의 음절수 100자 이상 132 2.7 len_word int Y 답변의 어절수 30 2.8 feature dictionary Y 채점 자질 {문장수:4, 형용사:3, ...} 가공 데이터 명세(공통)

가공 데이터 명세(공통) 구분 속성명 타입 필수 여부 설명 범위 비고 3 expert object Y 전문가 정보 - 3.1 score object Y 점수 측정 전문가 - 3.1.1 votes_1 object Y 전문가 1 - 3.1.1.1 id string Y 전문가 1 아이디 V01 3.1.1.2 gender string Y 전문가 1 성별 남, 여 3.1.1.3 age int Y 전문가 1 나이 46 3.1.1.4 career int Y 전문가 1 경력 2 3.1.2 votes_2 object Y 전문가 2 - 3.1.2.1 id string Y 전문가 2 아이디 V02 3.1.2.2 gender string Y 전문가 2 성별 남, 여 3.1.2.3 age int Y 전문가 2 나이 36 3.1.2.4 career int Y 전문가 2 경력 2 3.2 feedback object Y 피드백 전문가 - 3.2.1 votes_1 object Y 피드백 전문가 1 - 3.2.1.1 id string Y 아이디 V03 3.2.1.2 gender string Y 성별 남, 여 3.2.1.3 age int Y 나이 49 3.2.1.4 career int Y 경력 2 4 score object Y 평가 - 4.1 personal object Y 전문가 평가 - 4.1.1 holistic object Y 전문가 총체적 평가 - 4.1.1.1 score array Y 정량적 평가 1, 2, 3, 4, 5 [1, 4] 4.1.1.2 feedback string Y 정성적 평가 글을 체계적으로.. 4.1.1.3 len_syllable int Y 피드백 음절수 70 4.1.1.4 len_word int Y 피드백 어절수 13 4.1.1.5 min_syllable int Y 피드백 최소 음절수 37 4.1.1.6 total_word int Y 피드백 어절수 합산 130 4.1.2 analytic object Y 전문가 분석적 평가 - 4.1.2.1 task_1 object Y 과제 토픽 1 - 4.1.2.1.1 score array Y 정량적 평가 [1, 4] 4.1.2.1.2 rubric_key string Y 관련 루브릭 키 A-00Z-1A-2A 4.1.2.1.3 feedback string Y 정성적 평가 글을 체계적으로.. 4.1.2.1.4 len_syllable int Y 피드백 음절수 70 4.1.2.1.5 len_word int Y 피드백 어절수 13 4.1.2.2 content_1 object Y 내용 토픽 1 - 4.1.2.2.1 score array Y 정량적 평가 [1, 4] 4.1.2.2.2 rubric_key string Y 관련 루브릭 키 A-00Z-1A-2A 4.1.2.2.3 feedback string Y 정성적 평가 글을 체계적으로.. 4.1.2.2.4 len_syllable int Y 피드백 음절수 70 4.1.2.2.5 len_word int Y 피드백 어절수 13 4.1.2.3 content_2 object Y 내용 토픽 2 - 4.1.2.3.1 score array Y 정량적 평가 [1, 4] 4.1.2.3.2 rubric_key string Y 관련 루브릭 키 A-00Z-1A-2A 4.1.2.3.3 feedback string Y 정성적 평가 글을 체계적으로.. 4.1.2.3.4 len_syllable int Y 피드백 음절수 70 4.1.2.3.5 len_word int Y 피드백 어절수 13 4.1.2.4 content_3 object Y 내용 토픽 3 - 4.1.2.4.1 score array Y 정량적 평가 [1, 4] 4.1.2.4.2 rubric_key string Y 관련 루브릭 키 A-00Z-1A-2A 4.1.2.4.3 feedback string Y 정성적 평가 글을 체계적으로.. 4.1.2.4.4 len_syllable int Y 피드백 음절수 70 4.1.2.4.5 len_word int Y 피드백 어절수 13 4.1.2.5 organization_1 object Y 조직 토픽 1 - 4.1.2.5.1 score array Y 정량적 평가 [1, 4] 4.1.2.5.2 rubric_key string Y 관련 루브릭 키 A-00Z-1A-2A 4.1.2.5.3 feedback string Y 정성적 평가 글을 체계적으로.. 4.1.2.5.4 len_syllable int Y 피드백 음절수 70 4.1.2.5.5 len_word int Y 피드백 어절수 13 4.1.2.6 organization_2 object Y 조직 토픽 2 - 4.1.2.6.1 score array Y 정량적 평가 [1, 4] 4.1.2.6.2 rubric_key string Y 관련 루브릭 키 A-00Z-1A-2A 4.1.2.6.3 feedback string Y 정성적 평가 글을 체계적으로.. 4.1.2.6.4 len_syllable int Y 피드백 음절수 70 4.1.2.6.5 len_word int Y 피드백 어절수 13 4.1.2.7 expression_1 object Y 표현 토픽 1 - 4.1.2.7.1 score array Y 정량적 평가 [1, 4] 4.1.2.7.2 rubric_key string Y 관련 루브릭 키 A-00Z-1A-2A 4.1.2.7.3 feedback string Y 정성적 평가 글을 체계적으로.. 4.1.2.7.4 len_syllable int Y 피드백 음절수 70 4.1.2.7.5 len_word int Y 피드백 어절수 13 4.1.2.8 expression_2 object Y 표현 토픽 2 - 4.1.2.8.1 score array Y 정량적 평가 [1, 4] 4.1.2.8.2 rubric_key string Y 관련 루브릭 키 A-00Z-1A-2A 4.1.2.8.3 feedback string Y 정성적 평가 글을 체계적으로.. 4.1.2.8.4 len_syllable int Y 피드백 음절수 70 4.1.2.8.5 len_word int Y 피드백 어절수 13 5 rubric object Y 루브릭 - 5.1 type string Y 루브릭 타입 서술형, 논술형... 5.2 purpose string Y 루브릭 목적 정보전달, 친교... 5.3 achievement string Y 해당 성취 기준 해당 성취 기준 5.4 analytic object Y 분석적 루브릭 - 5.4.1 task_1 object Y 과제 토픽 1 - 5.4.1.1 name string Y 과제 토픽 1 과제수행의 충실성 5.4.1.2 rubric_key string Y 루브릭 키 A-00Z-1A-2A 5.4.1.3 evaluation_1 string Y 1점 평가 기준 5.4.1.4 evaluation_2 string Y 2점 평가 기준 5.4.1.5 evaluation_3 string Y 3점 평가 기준 5.4.1.6 evaluation_4 string Y 4점 평가 기준 5.4.1.7 evaluation_5 string Y 5점 평가 기준 5.4.2 content_1 object Y 내용 토픽 1 - 5.4.2.1 name string Y 내용 토픽 1 설명의 명료성 5.4.2.2 rubric_key string Y 루브릭 키 A-00Z-1A-2A 5.4.2.3 evaluation_1 string Y 1점 평가 기준 5.4.2.4 evaluation_2 string Y 2점 평가 기준 5.4.2.5 evaluation_3 string Y 3점 평가 기준 5.4.2.6 evaluation_4 string Y 4점 평가 기준 5.4.2.7 evaluation_5 string Y 5점 평가 기준 5.4.3 content_2 object Y 내용 토픽 2 - 5.4.3.1 name string Y 내용 토픽 2 설명의 구체성 5.4.3.2 rubric_key string Y 루브릭 키 A-00Z-1A-2A 5.4.3.3 evaluation_1 string Y 1점 평가 기준 5.4.3.4 evaluation_2 string Y 2점 평가 기준 5.4.3.5 evaluation_3 string Y 3점 평가 기준 5.4.3.6 evaluation_4 string Y 4점 평가 기준 5.4.3.7 evaluation_5 string Y 5점 평가 기준 5.4.4 content_3 object Y 내용 토픽 3 - 5.4.4.1 name string Y 내용 토픽 3 설명의 적절성 5.4.4.2 rubric_key string Y 루브릭 키 A-00Z-1A-2A 5.4.4.3 evaluation_1 string Y 1점 평가 기준 5.4.4.4 evaluation_2 string Y 2점 평가 기준 5.4.4.5 evaluation_3 string Y 3점 평가 기준 5.4.4.6 evaluation_4 string Y 4점 평가 기준 5.4.4.7 evaluation_5 string Y 5점 평가 기준 5.4.5 organization_1 object Y 조직 토픽 1 - 5.4.5.1 name string Y 조직 토픽 1 문장의 연결성 5.4.5.2 rubric_key string Y 루브릭 키 A-00Z-1A-2A 5.4.5.3 evaluation_1 string Y 1점 평가 기준 5.4.5.4 evaluation_2 string Y 2점 평가 기준 5.4.5.5 evaluation_3 string Y 3점 평가 기준 5.4.5.6 evaluation_4 string Y 4점 평가 기준 5.4.5.7 evaluation_5 string Y 5점 평가 기준 5.4.6 organization_2 object Y 조직 토픽 2 - 5.4.6.1 name string Y 조직 토픽 2 글의 통일성 5.4.6.2 rubric_key string Y 루브릭 키 A-00Z-1A-2A 5.4.6.3 evaluation_1 string Y 1점 평가 기준 5.4.6.4 evaluation_2 string Y 2점 평가 기준 5.4.6.5 evaluation_3 string Y 3점 평가 기준 5.4.6.6 evaluation_4 string Y 4점 평가 기준 5.4.6.7 evaluation_5 string Y 5점 평가 기준 5.4.7 expression_1 object Y 표현 토픽 1 - 5.4.7.1 name string Y 표현 토픽 1 어휘의 적절성 5.4.7.2 rubric_key string Y 루브릭 키 A-00Z-1A-2A 5.4.7.3 evaluation_1 string Y 1점 평가 기준 5.4.7.4 evaluation_2 string Y 2점 평가 기준 5.4.7.5 evaluation_3 string Y 3점 평가 기준 5.4.7.6 evaluation_4 string Y 4점 평가 기준 5.4.7.7 evaluation_5 string Y 5점 평가 기준 5.4.8 expression_2 object Y 표현 토픽 2 - 5.4.8.1 name string Y 표현 토픽 2 어법의 정확성 5.4.8.2 rubric_key string Y 루브릭 키 A-00Z-1A-2A 5.4.8.3 evaluation_1 string Y 1점 평가 기준 5.4.8.4 evaluation_2 string Y 2점 평가 기준 5.4.8.5 evaluation_3 string Y 3점 평가 기준 5.4.8.6 evaluation_4 string Y 4점 평가 기준 5.4.8.7 evaluation_5 string Y 5점 평가 기준 ▶ 데이터 포맷

데이터 포맷 원시데이터 원천데이터 라벨링데이터 글쓰기 원고 (txt) 글쓰기 정제 데이터 (CSV) JSON 메타 데이터 (xls) 메타 데이터 (CSV)

▶ 실제예시

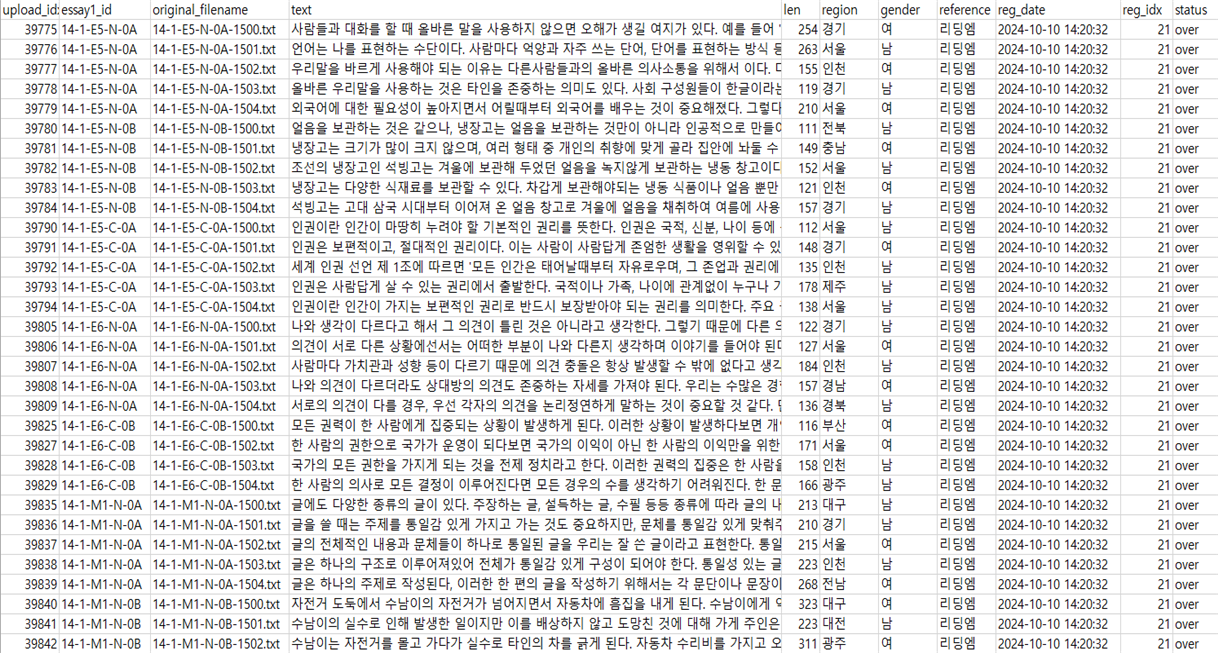

- 원시데이터 예시

그림1 원시데이터 예시- 원천데이터 예시

글쓰기 지시문 우리말을 바르게 사용해야 하는 까닭을 두 가지 이상 서술하세요. 학생 정보 학년: 초5 / 지역: 경기도 수원시 / 성별: 남 / 출처: 리딩엠 지시문 정보 100자 이상 / 키워드: 구성원, 존중, 오해, 의사소통 학생 답변 첫째, 우리말을 바르게 사용하는 것은 문화와 전통을 보존하는 데 중요한 역할을 합니다. 언어는 그 나라의 역사와 문화를 담고 있는 중요한 수단입니다. 우리가 우리말을 정확하게 사용함으로써 우리의 전통과 문화를 다음 세대에 온전히 전달할 수 있습니다. 만약 우리가 우리말을 소홀히 하거나 왜곡된 표현을 많이 사용한다면, 우리의 문화와 전통도 함께 왜곡될 가능성이 있습니다. 예를 들어, 전통적인 관용어구나 속담이 사라지면 그 속에 담긴 지혜와 가치도 함께 잃게 됩니다.

둘째, 바른 우리말 사용은 의사소통의 효율성을 높입니다. 언어는 사람들 간의 의사소통을 원활하게 하는 도구입니다. 우리가 정확한 단어를 사용하고 문법에 맞게 말을 한다면, 서로의 의도를 명확하게 전달할 수 있습니다. 그러나 잘못된 표현이나 모호한 단어 사용은 오해를 불러일으킬 수 있으며, 이는 의사소통을 방해하고 때로는 갈등을 초래할 수도 있습니다. 예를 들어, 공적인 자리에서 잘못된 단어 선택이나 문법 오류가 있는 발표는 전문성을 의심받을 수 있고, 이는 신뢰도에도 영향을 미칠 수 있습니다.

이 외에도 우리말을 바르게 사용하는 것은 사회적 신뢰를 구축하는 데 기여하고, 나아가 우리의 정체성을 지키는 데 중요한 역할을 합니다. 따라서 우리말을 바르게 사용하는 것은 개인뿐만 아니라 사회 전체의 발전과 화합을 위해 매우 중요합니다.- 라벨링데이터 예시(json)

그림2 라벨링데이터 예시1

그림3 라벨링데이터 예시2 -

데이터셋 구축 담당자

수행기관(주관) : ㈜유핏

수행기관(주관) 책임자명 전화번호 대표이메일 담당업무 김희곤 1544-9730 koscokim@ufits.co.kr 사업총괄 관리, 데이터 가공, 검수, 저작도구 수행기관(참여)

수행기관(참여) 기관명 담당업무 ㈜리딩엠 글쓰기 데이터 획득/수집 메가스터디교육(주) AI학습모델 밸류웨이(주) 데이터 정제 데이터 관련 문의처

데이터 관련 문의처 담당자명 전화번호 이메일 ㈜유핏 안동철 070-4012-1836 ceo@ufits.co.kr ㈜유핏 안동철 070-4012-1836 koscokim@ufits.co.kr AI모델 관련 문의처

AI모델 관련 문의처 담당자명 전화번호 이메일 메가스터디교육(주) 최의진 02-3489-8619 choiuijin1125@megastudy.net 메가스터디교육(주) 손동협 02-3489-8619 acer@megastudy.net 저작도구 관련 문의처

저작도구 관련 문의처 담당자명 전화번호 이메일 ㈜유핏 안동철 070-4012-1836 ceo@ufits.co.kr ㈜유핏 김희곤 070-4012-1836 koscokim@ufits.co.kr

-

인터넷과 물리적으로 분리된 온라인·오프라인 공간으로 의료 데이터를 포함하여 보안 조치가 요구되는 데이터를 다운로드 없이 접근하고 분석 가능

* 온라인 안심존 : 보안이 보장된 온라인 네트워크를 통해 집, 연구실, 사무실 등 어디서나 접속하여 데이터에 접근하고 분석

* 오프라인 안심존 : 추가적인 보안이 필요한 데이터를 대상으로 지정된 물리적 공간에서만 접속하여 데이터에 접근하고 분석 -

- AI 허브 접속

신청자 - 안심존

사용신청신청자신청서류 제출* - 심사구축기관

- 승인구축기관

- 데이터 분석 활용신청자

- 분석모델반출신청자

- AI 허브 접속

-

1. 기관생명윤리위원회(IRB) 심의 결과 통지서 [IRB 알아보기] [공용IRB 심의신청 가이드라인]

2. 기관생명윤리위원회(IRB) 승인된 연구계획서

3. 신청자 소속 증빙 서류 (재직증명서, 재학증명서, 근로계약서 등 택1)

4. 안심존 이용 신청서 [다운로드]

5. 보안서약서 [다운로드]

※ 상기 신청서 및 첨부 서류를 완비한 후 신청을 진행하셔야 정상적으로 절차가 이루어집니다. -

신청 및 이용관련 문의는 safezone1@aihub.kr 또는 02-525-7708, 7709로 문의

데이터셋 다운로드 승인이 완료 된 후 API 다운로드 서비스를 이용하실 수 있습니다.

API 다운로드 파일은 분할 압축되어 다운로드 됩니다. 분할 압축 해제를 위해서는 분할 압축 파일들의 병합이 필요하며 리눅스 명령어 사용이 필요합니다.

리눅스 OS 계열에서 다운로드 받으시길 권장하며 윈도우에서 파일 다운로드 시 wsl(리눅스용 윈도우 하위 시스템) 설치가 필요합니다.

※ 파일 병합 리눅스 명령어

find "폴더경로" -name "파일명.zip.part*" -print0 | sort -zt'.' -k2V | xargs -0 cat > "파일명.zip"

- 해당 명령어 실행 시, 실행 경로 위치에 병합 압축 파일이 생성됩니다.

- 병합된 파일 용량이 0일 경우, 제대로 병합이 되지 않은 상태이니 "폴더경로"가 제대로 입력되었는지 확인 부탁드립니다.

※ 데이터셋 소개 페이지에서 다운로드 버튼 클릭하여 승인이 필요합니다.

오프라인 데이터 이용 안내

본 데이터는 K-ICT 빅데이터센터에서도 이용하실 수 있습니다.

다양한 데이터(미개방 데이터 포함)를 분석할 수 있는 오프라인 분석공간을 제공하고 있습니다.

데이터 안심구역 이용절차 및 신청은 K-ICT빅데이터센터 홈페이지를 참고하시기 바랍니다.

국방데이터 개방 안내

본 데이터는 국방데이터로 군사 보안에 따라 AI허브에서 데이터를 제공하지 않으며,

군 담당자를 통한 별도의 사용 신청이 필요합니다.