BETA 대규모 물리환경 로봇조작 데이터

- 분야로보틱스

- 유형 센서 , 이미지

- 생성 방식LMM

※ 25년 신규 개방되는 데이터로, 데이터 활용성 검토, 이용자 관점의 개선의견 수렴 등을 통해 수정/보완될 수 있으며 최종데이터, 샘플데이터, 산출물 등은 변경될 수 있습니다.

-

데이터 변경이력

데이터 변경이력 버전 일자 변경내용 비고 1.0 2025-04-16 데이터 개방 Beta Version 데이터 히스토리

데이터 히스토리 일자 변경내용 비고 2025-04-16 산출물 전체 공개 소개

실제와 가상환경에서 취득한 RGB-D이미지와 그에 대응하는 로봇관절각도, End-effector 포즈, 힘/토크, 촉각데이터로 구성 된 로봇 그리퍼로 200종 이상의 물체를 조작하는 대규모 물리 환경 로봇 조작 데이터

구축목적

물리 환경에서 로봇의 자율 조작 능력은 다양한 산업에서 필수요소로 자리잡았으며, 이를 위해 로봇이 다양한 물체와 환경에 대한 이해와 적응 능력을 갖출 수 있도록 이미지와 텍스트 데이터 기반의 VLA 데이터 구축을 목적으로 함

-

메타데이터 구조표 데이터 영역 로보틱스 데이터 유형 센서 , 이미지 데이터 형식 png 데이터 출처 자체 수집 라벨링 유형 이미지 캡션 라벨링 형식 json 데이터 활용 서비스 로봇의 물체 인식 / 조작 계획 / 제어 알고리즘 개발 데이터 구축년도/

데이터 구축량2024년/262,166 세트 -

데이터 구축 규모

● 학습용 데이터 구성(라벨링데이터 JSON 기준)데이터 구축 규모-학습용 데이터 구성 데이터 구축 총량(100%) 학습 데이터 (80%) 테스트 데이터 (10%) 262,166 238,266 23,900 ● 원천데이터

데이터 구축 규모-원천데이터 데이터종류 파일포맷 데이터 규모 비고 RGB 이미지 png 262,166 Depth 이미지 png 262,166 ● 라벨링데이터

데이터 구축 규모-라벨링데이터 데이터 종류 파일포맷 데이터 규모 라벨링 유형 비고 라벨링 데이터 json 262,166개 한국어 이미지 캡션 한국어, 영어 캡션 문장과

로봇 센서 데이터를

1개의 파일로 병합영어 이미지 캡션 데이터 분포

원천데이터 대비 가공(라벨링) 데이터 분포데이터 분포-원천데이터 대비 가공(라벨링) 데이터 분포 원천 데이터 분류 포맷 수량 단위 분포 비율 실제환경 png (RGB 이미지) 77,984 장 14.29% png (Depth 이미지) 77,984 장 가상환경 png (RGB 이미지) 184,182 장 85.71% png (Depth 이미지) 184,182 장 합계 524,332 100% 데이터 분포-원천데이터 대비 가공(라벨링) 데이터 분포 2 가공(라벨링) 데이터 분류 형식 포맷 수량 단위 파일 비율 실제환경 이미지 캡셔닝 JSON 77,984 건 1:01 가상환경 이미지 캡셔닝 JSON 184,182 건 1:01 합계 524,332 -

-

AI 모델 상세 설명서 다운로드

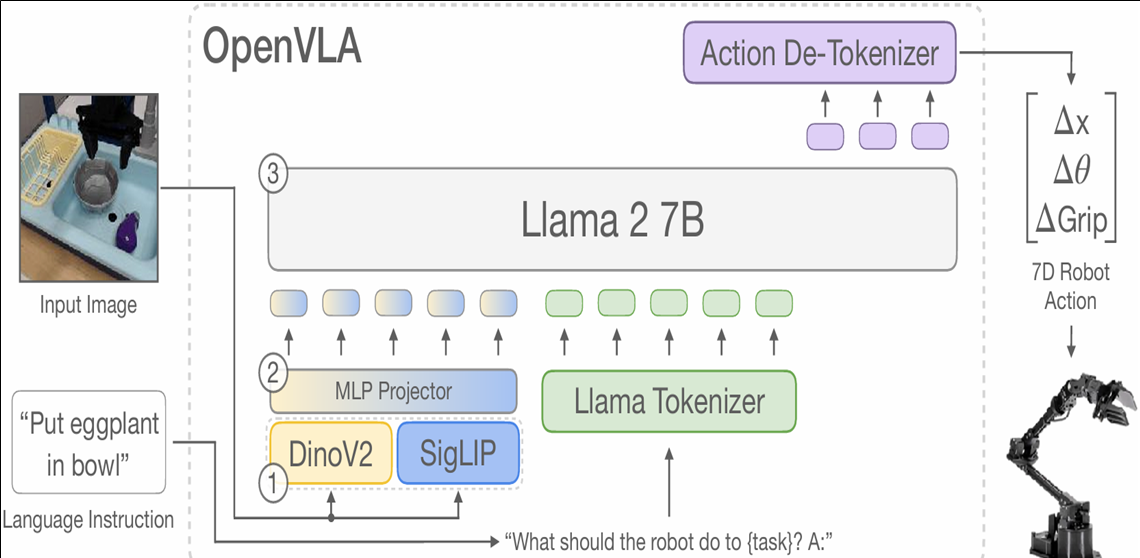

AI 모델 상세 설명서 다운로드 AI 모델 다운로드OpenVLA

● 평균적으로 가장 높은 VLA(Vision-Language-Action) task 수행 능력과 강건한 일반화 성능을 갖는 OpenVLA 모델을 기반으로 학습 모델 구현

● OpenVLA 모델을 이용하여 로봇의 action 값 예측

● OpenVLA는 VLM(Vision Language Model)과 LLM(Large Language Model)으로 구성이 되어 시각 데이터와 언어 데이터를 함께 처리할 수 있음

● 사용자의 지시와 카메라가 촬영하는 장면(이미지)을 입력받아, 로봇 팔의 end effector pose 값 6개와 gripper의 넓이 값으로 구성된 7차원 action vector를 예측하도록 설계됨

● 모델 내 LLM은 7개의 문자(characters)를 출력하며, 각 문자는 사전에 정의된 256개의 토큰 중 하나로 변환됨. 이 토큰을 각각 –1과 1사이의 값에 맵핑하여 최종 action state를 output으로 반환함.

[ OpenVLA 모델 구조 ] -

설명서 및 활용가이드 다운로드

데이터 설명서 다운로드 구축활용가이드 다운로드□ 데이터 구성

데이터 구성-예시 예시 R_GD_K16_6_r1_1000.png ① ② ③ ④⑤ ⑥ ⑦ 데이터 구성-세부 구성 정보 구분 세부 구성 정보 ① 환경

분류- R: 실제 환경

- S: 가상 환경② 로봇팔

행동

분류G 잡기 Grasp L 들기 Lift M 옮기기 Move Pl 놓기 Place Pu 밀기 Push D 끌기 Drag S 쌓기 Stack Pr 누르기 Press ③ 배경

구분

번호공간 컨셉 인테리어

번호벽지 색 배경 번호 부엌

Kitchenenv_1 white(흰색) K1 ivory(상아색) K2 green(초록색) K3 env_2 white(흰색) K4 ivory(상아색) K5 green(초록색) K6 env_3 white(흰색) K7 ivory(상아색) K8 green(초록색) K9 env_4 white(흰색) K10 ivory(상아색) K11 green(초록색) K12 env_5 white(흰색) K13 ivory(상아색) K14 green(초록색) K15 env_6 blue(파란색) K16 gray(회색) K17 사무실

Officeenv_1 white(흰색) O1 ivory(상아색) O2 green(초록색) O3 env_2 white(흰색) O4 ivory(상아색) O5 green(초록색) O6 env_3 white(흰색) O7 ivory(상아색) O8 green(초록색) O9 env_4 white(흰색) O10 ivory(상아색) O11 green(초록색) O12 env_5 white(흰색) O13 ivory(상아색) O14 green(초록색) O15 env_6 blue(파란색) O16 gray(회색) O17 거실

Living roomenv_1 white(흰색) L1 ivory(상아색) L2 green(초록색) L3 env_2 white(흰색) L4 ivory(상아색) L5 green(초록색) L6 env_3 white(흰색) L7 ivory(상아색) L8 green(초록색) L9 env_4 white(흰색) L10 ivory(상아색) L11 green(초록색) L12 env_5 white(흰색) L13 ivory(상아색) L14 green(초록색) L15 env_6 blue(파란색) L16 gray(회색) L17 ④ 물체

구분

번호로봇이 상호작용하는 물체의 구분 번호 ⑤ 촬영

각도● r1: 로봇 팔이 정면에서 보일 수 있는 시야각에서 ±15°의 RGB 데이터

● r2: 로봇 팔이 측면에서 보일 수 있는 시야각에서 ±15°의 RGB 데이터

● d1: 로봇 팔이 정면에서 보일 수 있는 시야각에서 ±15°의 depth 데이터

● d2: 로봇 팔이 측면에서 보일 수 있는 시야각에서 ±15°의 depth 데이터⑥ 파일명

순서실험번호(첫 한자리) + 프레임 번호(나머지 세 자리)

e.g. 1000: 1번째 실험의 000번 프레임 데이터⑦ 데이터

구분● png: 원천 이미지 데이터

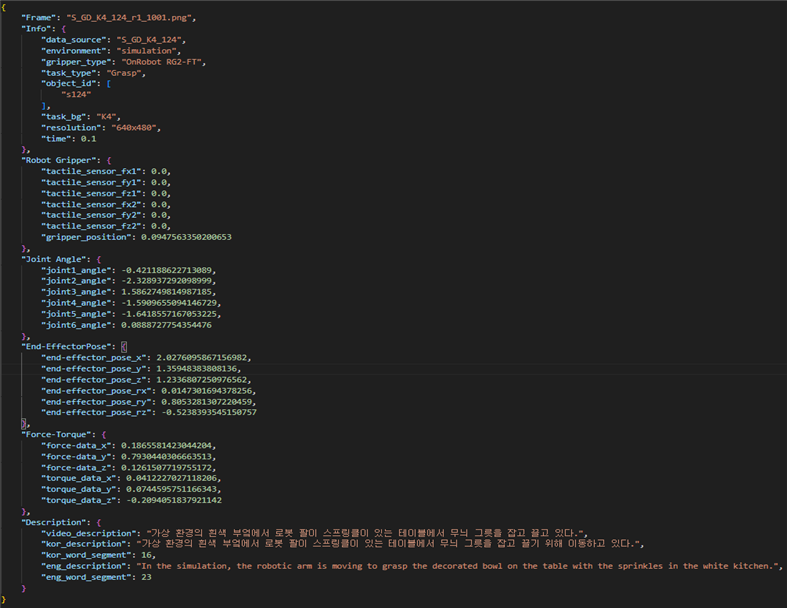

● json: 라벨링 데이터□ 어노테이션 포맷

어노테이션 포맷 번호 항목명 타입 필수

여부설명 예시 1 Frame String Y 이미지 파일명 "S_GD_L9_10_d1_1000.png" 2 Info 정보 데이터 2-1 data_source String Y 원천 데이터 “S_GD_L9_10” 2-2 environment String Y 환경 “simulation” 2-3 gripper_type String Y 그리퍼 종류 “OnRobot RG2-FT” 2-4 task_type String Y 로봇 작업 종류 "Grasp" 2-5 object_id Array

[string]Y 오브젝트 종류 ["s10"] 2-6 task_bg String Y 작업 배경 종류 "L9" 2-7 resolution String Y 이미지 해상도 “640x480” 2-8 time number Y 촬영 시각 (time step) 0 3 Robot Gripper 로봇 그리퍼 3-1 tactile_sensor_fx1 number Y 로봇그리퍼(N) tactile_sensor1_force_x 0 3-2 tactile_sensor_fy1 number Y 로봇그리퍼(N) tactile_sensor1_force_y 0 3-3 tactile_sensor_fz1 number Y 로봇그리퍼(N) tactile_sensor1_force_z 0 3-4 tactile_sensor_fx2 number Y 로봇그리퍼(N) tactile_sensor2_force_x 0 3-5 tactile_sensor_fy2 number Y 로봇그리퍼(N) tactile_sensor2_force_y 0 3-6 tactile_sensor_fz2 number Y 로봇그리퍼(N) tactile_sensor2_force_z 0 3-7 gripper_position number Y 그리퍼 위치 정보(mm) 0.098379128 4 Joint Angle 각도 데이터 4-1 joint1_angle number Y 로봇 조인트1 정보(rad) -0.785398185 4-2 joint2_angle number Y 로봇 조인트2 정보(rad) -2.356194496 4-3 joint3_angle number Y 로봇 조인트3 정보(rad) 1.570796371 4-4 joint4_angle number Y 로봇 조인트4 정보(rad) -1.570796371 4-5 joint5_angle number Y 로봇 조인트5 정보(rad) -1.570796371 4-6 joint6_angle number Y 로봇 조인트6 정보(rad) 0 5 End-EffectorPose 5-1 end-effector_pose_x number Y End-effector 포즈_x(mm) 1.71125257 5-2 end-effector_pose_y number Y End-effector 포즈_y(mm) 1.671747446 5-3 end-effector_pose_z number Y End-effector 포즈_z(mm) 0.740706086 5-4 end-effector_pose_rx number Y End-effector 포즈_rx(rad) -0.000000295 5-5 end-effector_pose_ry number Y End-effector 포즈_ry(rad) 0.785398185 5-6 end-effector_pose_rz number Y End-effector 포즈_rz(rad) -2.356194019 6 Force-Torque 힘/토크 데이터 6-1 force-data_x number Y 상호작용 force_x(N) 0 6-2 force-data_y number Y 상호작용 force_y(N) 0 6-3 force-data_z number Y 상호작용 force_z(N) 0 6-4 torque_data_x number Y 상호작용 torque_x(Nm) 0 6-5 torque_data_y number Y 상호작용 torque_y(Nm) 0 6-6 torque_data_z number Y 상호작용 torque_z(Nm) 0 7 Description - 설명문 7-1 video_description String Y 시퀀스 영상 설명문 "가상환경의 초록색 거실에서 로봇 팔이 그릇을 잡아 끌기 위해 이동하고 있다" 7-2 kor_description String Y 한국어 설명문 "가상환경의 초록색 거실에서 로봇 팔이 그릇을 잡기 위해 이동하고 있다." 7-3 kor_word_segment number Y 한국어캡션 어절 수 10 7-4 eng_description String Y 영문 설명문 "In the simulation, the robotic arm is moving to grasp the bowl in the green living room." 7-5 eng_word_segment number Y 영어캡션 어절 수 17 □ 데이터 포맷

- 원천 이미지 데이터(png) 1장에 대해 1:1 매칭되는 레이블 데이터(json)

- 원천 이미지 데이터와 레이블 데이터는 동일한 파일명 보유 (파일 확장자 제외)□ 실제 예시

![이미지 데이터, S_GD_K4_124_r1_1001.png]](/web-nas/aihub21/files/editor/2025/03/4adb6c589c9e4d9a989aa7f72a9529d7.png)

[이미지 데이터, S_GD_K4_124_r1_1001.png]

[레이블 데이터, S_GD_K4_124_r1_1001.json]

-

데이터셋 구축 담당자

수행기관(주관) : 써로마인드

수행기관(주관) 책임자명 전화번호 대표이메일 담당업무 장하영 02-872-5127 contact@surromind.a 사업 총괄·관리, AI 모델 개발 및 유효성 검증 수행기관(참여)

수행기관(참여) 기관명 담당업무 ㈜오픈유아이 데이터 가공, 데이터 검수, 데이터 품질관리 동국대학교 산학협력단 데이터 수집, 데이터 정제 데이터 관련 문의처

데이터 관련 문의처 담당자명 전화번호 이메일 장하영 02-872-5127 contact@surromind.a 김소연 02-872-5127 contact@surromind.a AI모델 관련 문의처

AI모델 관련 문의처 담당자명 전화번호 이메일 장하영 02-872-5127 contact@surromind.a 김소연 02-872-5127 contact@surromind.a 저작도구 관련 문의처

저작도구 관련 문의처 담당자명 전화번호 이메일 이권희 02-857-3095 openui@openui.co.kr 제강철우 02-857-3095 openui@openui.co.kr

-

인터넷과 물리적으로 분리된 온라인·오프라인 공간으로 의료 데이터를 포함하여 보안 조치가 요구되는 데이터를 다운로드 없이 접근하고 분석 가능

* 온라인 안심존 : 보안이 보장된 온라인 네트워크를 통해 집, 연구실, 사무실 등 어디서나 접속하여 데이터에 접근하고 분석

* 오프라인 안심존 : 추가적인 보안이 필요한 데이터를 대상으로 지정된 물리적 공간에서만 접속하여 데이터에 접근하고 분석 -

- AI 허브 접속

신청자 - 안심존

사용신청신청자신청서류 제출* - 심사구축기관

- 승인구축기관

- 데이터 분석 활용신청자

- 분석모델반출신청자

- AI 허브 접속

-

1. 기관생명윤리위원회(IRB) 심의 결과 통지서 [IRB 알아보기] [공용IRB 심의신청 가이드라인]

2. 기관생명윤리위원회(IRB) 승인된 연구계획서

3. 신청자 소속 증빙 서류 (재직증명서, 재학증명서, 근로계약서 등 택1)

4. 안심존 이용 신청서 [다운로드]

5. 보안서약서 [다운로드]

※ 상기 신청서 및 첨부 서류를 완비한 후 신청을 진행하셔야 정상적으로 절차가 이루어집니다. -

신청 및 이용관련 문의는 safezone1@aihub.kr 또는 02-525-7708, 7709로 문의

데이터셋 다운로드 승인이 완료 된 후 API 다운로드 서비스를 이용하실 수 있습니다.

API 다운로드 파일은 분할 압축되어 다운로드 됩니다. 분할 압축 해제를 위해서는 분할 압축 파일들의 병합이 필요하며 리눅스 명령어 사용이 필요합니다.

리눅스 OS 계열에서 다운로드 받으시길 권장하며 윈도우에서 파일 다운로드 시 wsl(리눅스용 윈도우 하위 시스템) 설치가 필요합니다.

※ 파일 병합 리눅스 명령어

find "폴더경로" -name "파일명.zip.part*" -print0 | sort -zt'.' -k2V | xargs -0 cat > "파일명.zip"

- 해당 명령어 실행 시, 실행 경로 위치에 병합 압축 파일이 생성됩니다.

- 병합된 파일 용량이 0일 경우, 제대로 병합이 되지 않은 상태이니 "폴더경로"가 제대로 입력되었는지 확인 부탁드립니다.

※ 데이터셋 소개 페이지에서 다운로드 버튼 클릭하여 승인이 필요합니다.

오프라인 데이터 이용 안내

본 데이터는 K-ICT 빅데이터센터에서도 이용하실 수 있습니다.

다양한 데이터(미개방 데이터 포함)를 분석할 수 있는 오프라인 분석공간을 제공하고 있습니다.

데이터 안심구역 이용절차 및 신청은 K-ICT빅데이터센터 홈페이지를 참고하시기 바랍니다.

국방데이터 개방 안내

본 데이터는 국방데이터로 군사 보안에 따라 AI허브에서 데이터를 제공하지 않으며,

군 담당자를 통한 별도의 사용 신청이 필요합니다.