-

데이터 변경이력

데이터 변경이력 버전 일자 변경내용 비고 1.0 2023-10-30 데이터 최초 개방 1.0 2023-06-14 데이터 개방 (Beta Version) 데이터 히스토리

데이터 히스토리 일자 변경내용 비고 2023-11-27 산출물 전체 공개 2023-09-12 메타데이터 수정 소개

- 인공지능 학습용 다국어 방송콘텐츠 번역 말뭉치 구축 방송 콘텐츠 분야의 영어, 스페인어, 러시아어 통·번역 성능 향상을 통해 한국 문화 확산 및 콘텐츠 산업 활성화를 위한 한국어 방송 콘텐츠의 인공지능 학습용 통·번역 데이터 - 상황별 신조어, 약어, 은어, 관용적 의미와 어투까지 효과적으로 전달할 수 있는 인공신경망기계번역(Neural Machine Translation; NMT)용 한-영어/스페인어,러시아어 통·번역 음성 및 텍스트 pair 데이터

구축목적

대규모 양질의 방송콘텐츠 통번역용 인공지능 학습데이터를 구축하고 공개함으로써 상대적으로 취약한 방송 콘텐츠 분야 한국어와 영어 간의 인공지능 통번역 성능 향상 및 이를 통해 방송콘텐츠 확산과 활성화에 기여하기 위함 - 범용성 높은 방송콘텐츠 분야를 선정하여 구축함 - 고품질 인공지능 학습데이터를 확보하여 활용성을 높임 데이터 구축 목표: - 한-영, 한-러, 한-스 통번역 번역말뭉치 데이터 각각 50만 문장(총 150만 문장) - 영-한, 러-한, 스-한 통번역 번역말뭉치 데이터 각각 15만 문장(총 45만 문장)

-

메타데이터 구조표 데이터 영역 한국어 데이터 유형 텍스트 데이터 형식 json 데이터 출처 방송사와 저작권 계약을 통해 콘텐츠 수집 라벨링 유형 번역(자연어) 라벨링 형식 json 데이터 활용 서비스 다국어 통역기, 다국어 영상 자막 자동 생성 서비스 데이터 구축년도/

데이터 구축량2022년/- 방송콘텐츠 한국어 및 다국어 원천데이터 1,958,601개(JSON, 488.37MB) 한국어 원천데이터 1,505,574개 문장(JSON, 366.06MB) 영어/스페인어/러시아어 원천데이터 453,027개 문장(JSON, 122.42MB) - 한국어-영어/스페인어/러시아어 양방향 라벨링 번역테이터 1,958,601개(JSON, 1.23GB) 한국어-영어/스페인어/러시아어 번역 말뭉치 데이터 1,505,574개 문장(JSON, 912.62MB) 영어/스페인어/러시아어-한국어 번역 말뭉치 데이터 453,027개 문장(JSON, 316.16MB) -

1. 데이터 구축 규모

방송콘텐츠 한국어-영어/스페인어/러시아어 양방향 번역 말뭉치 약 195만개구분 종류 형태 포맷 언어 규모 원천 방송콘텐츠 텍스트 json 한국어 약 150만개 문장 데이터 텍스트 json 영어, 스페인어, 러시아어 약 45만개 문장 라벨링데이터 텍스트 json 한국어-영어/스페인어/ 러시아어 약 150만개 문장 텍스트 json 영어/스페인어/러시아어-한국어 약 45만개 문장 2. 데이터 분포

- 방송콘텐츠 대분류 5개 이상으로 데이터 편향 없이 균등하게 설계 구축

- 다양한 화자, 발화 스타일, 다양한 주제, 분야가 반영될 수 있는 카테고리 등 데이터 전체 구성 방안 및 균형적인 분포

(1-009-032) 방송콘텐츠 한국어-영어 번역 말뭉치분류 언어방향 구축문장쌍 언어방향 구축문장쌍 다큐 한국어- 100,000문장 영어/스페인어/러시아어 50,000문장 교양 영어/스페인어/러시아어 100,000문장 -한국어 연예, 공연 (각 50만) 100,000문장 (각 15만) 영화, 드라마 50,000문장 50,000문장 오락, 예능 100,000문장 인터뷰/기타 50,000문장 50,000문장 합계 500,000문장 150,000문장 대분류 중분류 소분류 문장수 다큐 KBS, MBN 다큐인사이드, 리얼다큐숨, 사노라면, 생생정보마당등 100,000

(20%)교양 KBS, MBN, CJENM 천사의 컬렉션, 질문하는 기자들Q, 같이 삽시다, 생생정보마당, 썬킴의한국사 완전정복 등 100,000

(20%)연예/공연 KBS, MBN, CJENM 연예가중계, 옥탑방의 문제아들, 연애 DNA 연구소, 알토란, 이연LEEYEON 등 100,000

(20%)드라마/영화 KBS, CJENM, TVN, SHOWBOX, KPSFF 영혼수선공,경찰수업, 하트털이, 나의 아저씨, 머니게임, 반의반, 보이스4, 터널 등 50,000

(10%)예능/오락 KBS, MBN, CJENM 배틀트립, 님과함께, 모던패밀리, 알토란, IT's okay 잇츠오케이, Korean Studio 등 100,000

(20%)인터뷰 MBN, CJENM 토요포커스, sellev(셀레브),Skim On West 등 50,000

(10%)대분류 중분류 소분류 문장 수 다큐/교양 ELDA 해당없음 50,000 (33.3%) 영화/드라마 ELDA 해당없음 50,000 (33.3%) 기타 CJENM DKDKTV, joanday, Blimey, ConCoreaTV, TyJloveEcukor, Ariana Bonita 아리아나 보니따, Love Korea, 토기모치KOREA, 나도나도DoDo 50,000 (33.3%) -

-

AI 모델 상세 설명서 다운로드

AI 모델 상세 설명서 다운로드 AI 모델 다운로드1. 학습 AI모델

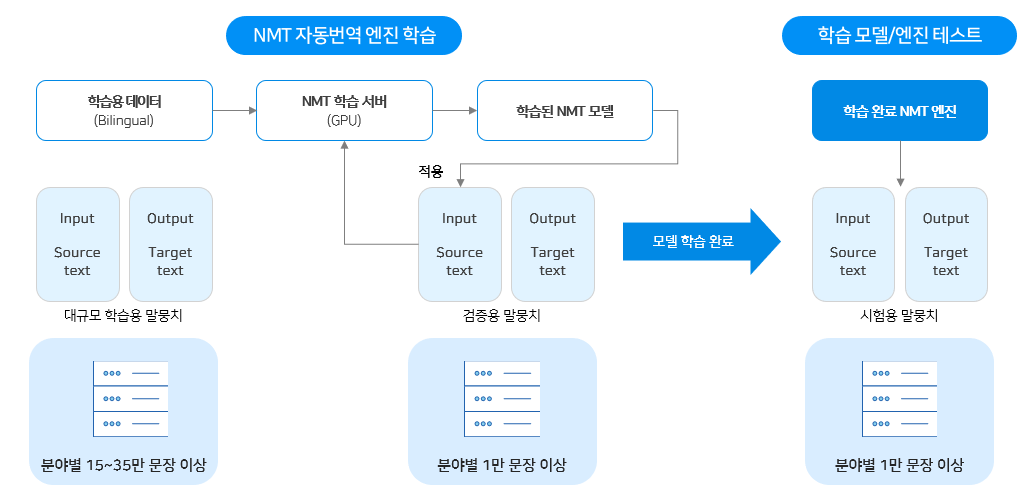

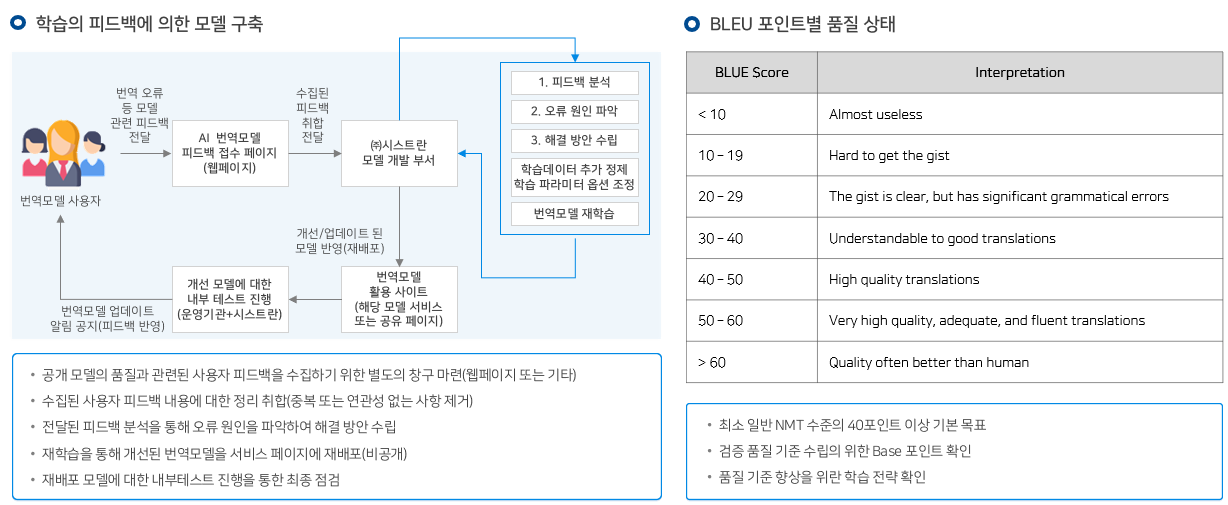

- 특화 번역모델의 번역품질 평가 방안으로 BLEU 평가 활용

- 구축한 데이터의 유효성을 검증하기 위하여 가공이 완료된 본 데이터를 인공지능 학습 모델을 통해 검증

- 다국어로 번역하여 구축한 통번역 데이터의 유효성 검증을 입증하기 위해 Attention 기반의 Transformer 알고리즘을 통해 번역 모델을 구성

- 학습된 번역 모델로 실제 구축한 데이터를 검증하기 위해 BLEU라고 하는 범용적인 자동 평가 도구를 사용

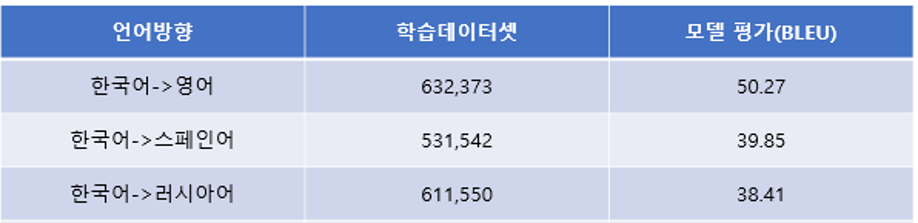

- 모델 구축은 언어별로 진행하였으며, 그 중 한영 병렬 말뭉치가 가장 많은 63만 문장쌍이며, 가장 적은 언어는 한불 47만 문장쌍임

- 언어별 학습을 통해 BLEU를 평가한 결과 한영 번역 모델이 가장 높은 50.27로 나왔고 가장 낮은 언어셋은 한러 38.41로 나옴

- 이러한 결과는 사업 제안서에서 제시한 BLEU 평가 점수 38을 모두 넘는 수치로 이는 구축한 다국어 번역 말뭉치 데이터 역시 그 품질이 우수함을 입증함

2. 데이터 활용

1) 데이터 활용데이터명 AI 모델 모델 성능 지표 응용서비스(예시) 방송콘텐츠 한국어 영어 번역말뭉치 한국문화 특화 번역모델 BLEU 평가 방송콘텐츠 한-영어 양방향 AI 자동번역 서비스 (38점 이상) 2) 응용 서비스

○ 한국문화 특화 번역 모델로 K-콘텐츠 글로벌화를 위한 세종학당, 해외문화원 등을 통하여 K-콘텐츠 클라우드 번역 서비스

3) 응용서비스 개발

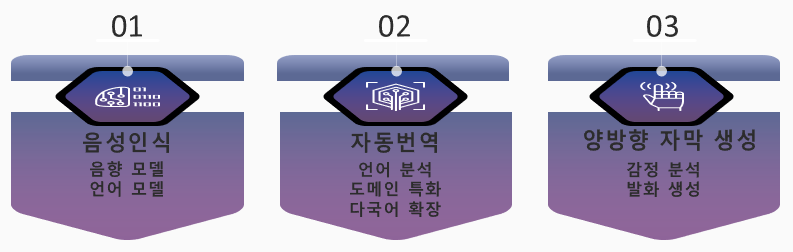

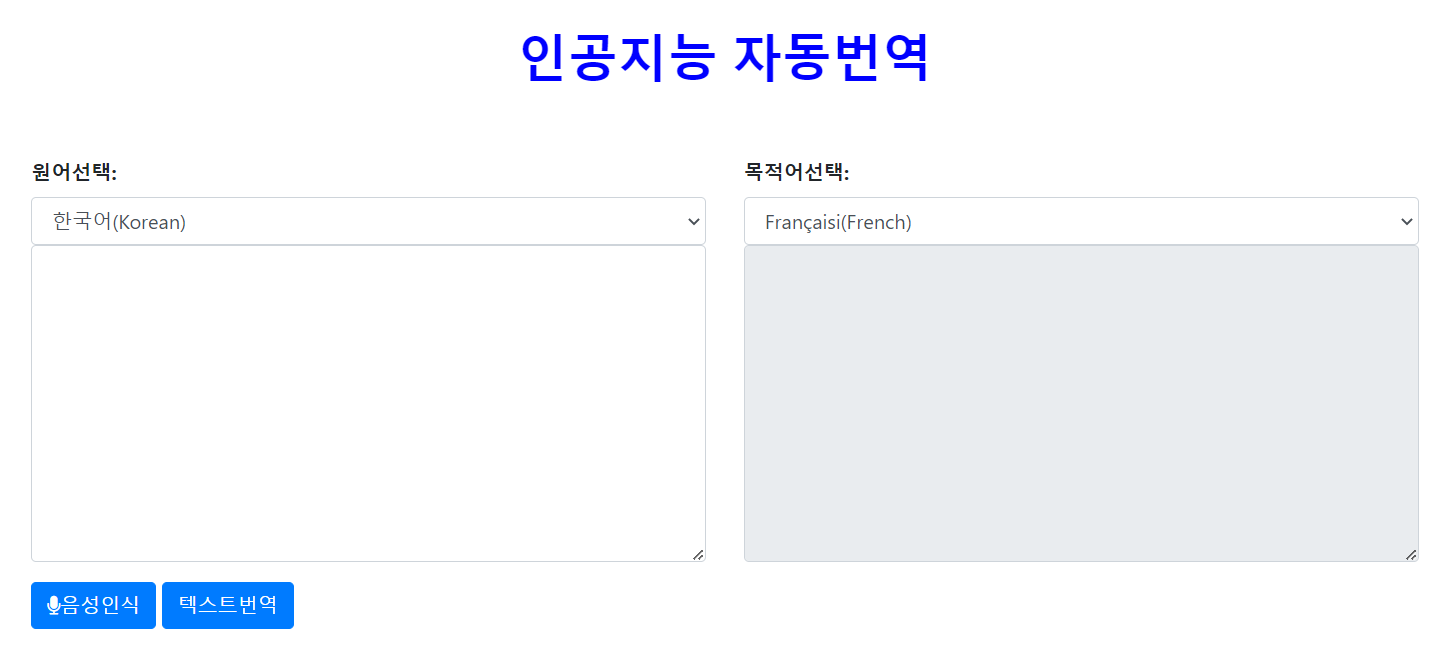

ㅇ다국어 통역기

- 한국어 음성을 인식해서 다국어로 통번역하는 웹서비스

- 인공지능 음성인식과 자동번역 학습모델을 활용하여 개발

- 도메인 특화 성능 고도화를 통해 고객 맞춤형 통번역 서비스 제공 가능

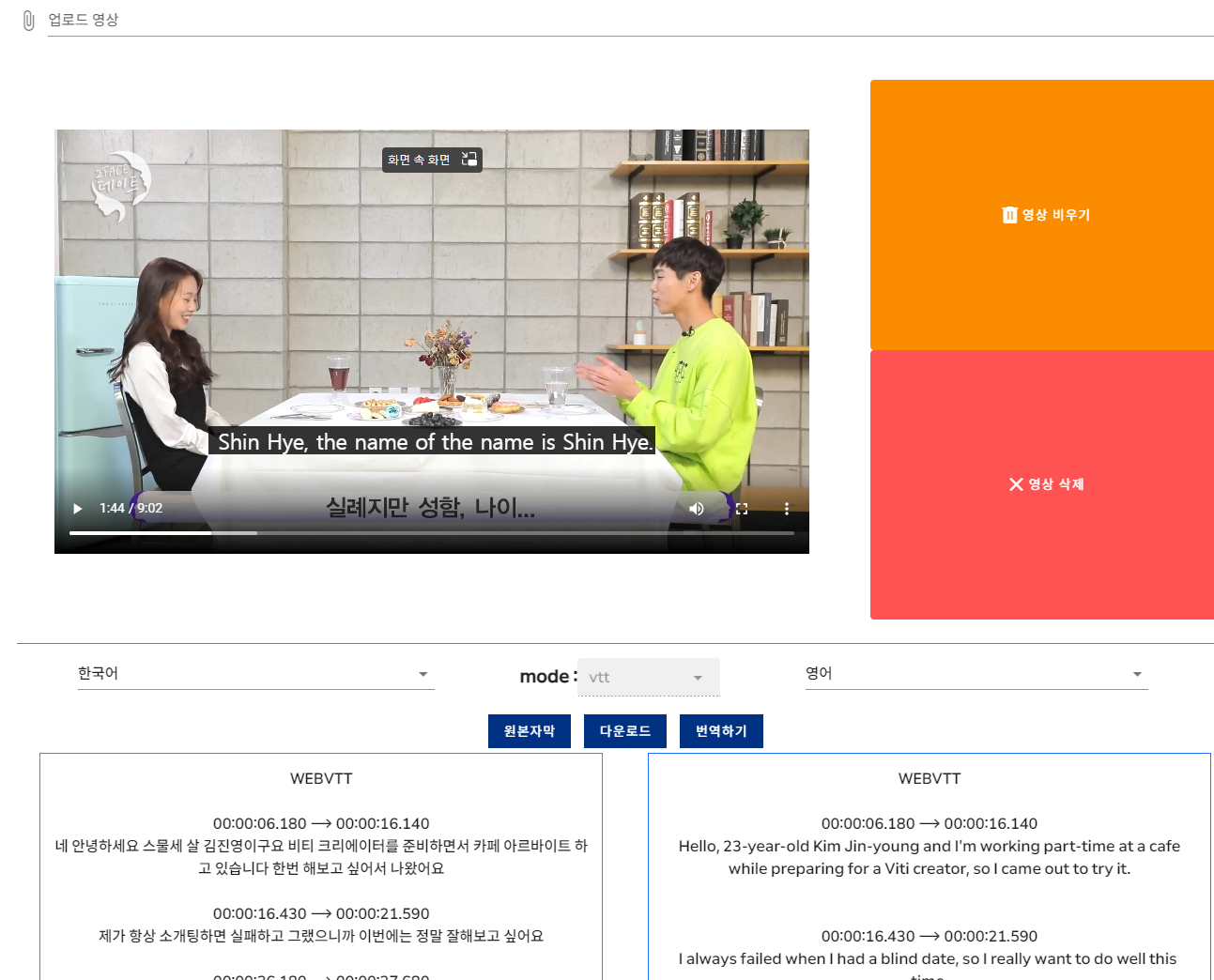

ㅇ 다국어 영상 자막 자동 생성 서비스

- 방송 및 유튜브 영상의 한국어 음성을 자동 인식

- 한국어 텍스트를 사용자가 선택한 다국어로 번역하여 자막을 자동으로 생성

- 정확도가 높을 경우 1시간 영상 기준으로 기존 자막화 시간 29시간에서 10분 이내로 단축할 수 있는 효율적인 서비스임

- 자막은 “srt” 또는 “vtt”형태로 다운로드 가능

- 영상 음성에 대한 인식 결과 또는 자동번역 오류가 있을 경우 이를 수정할 수 있는 편집 기능도 함께 제공

-

데이터 성능 점수

측정값 (%)기준값 (%)데이터 성능 지표

데이터 성능 지표 번호 측정항목 AI TASK 학습모델 지표명 기준값 점수 측정값 점수 1 방송콘텐츠 자동 번역(한>영) Machine Translation transformer (Attension 기반) BLEU 0.38 점 0.513699999999999 점 2 방송콘텐츠 자동 번역(한>스) Machine Translation transformer (Attension 기반) BLEU 0.35 점 0.4321 점 3 방송콘텐츠 자동 번역(한>러) Machine Translation transformer (Attension 기반) BLEU 0.38 점 0.3934 점

※ 데이터 성능 지표가 여러 개일 경우 각 항목을 클릭하면 해당 지표의 값이 그래프에 표기됩니다.

※ AI모델 평가 지표에 따라 측정값의 범위, 판단 기준이 달라질 수 있습니다. (ex. 오류율의 경우, 낮을수록 좋은 성능을 내는 것으로 평가됩니다)

-

설명서 및 활용가이드 다운로드

데이터 설명서 다운로드 구축활용가이드 다운로드1. 데이터 포맷

- 원천 음성 데이터 및 라벨링 번역 데이터 (한국어-다국어)No Field name Length Meaning a 대분류 2 rf(교양), dc(다큐), et(연예공연), md(영화드라마), vr(예능오락), iv(인터뷰) b 중분류 1 k(KBS), m(MBN), c(CJENM), t(tvN), s(ShowBox) c 순서 6 언어별 문장 순서로 매긴 번호 d 언어방향 4 koen(한-영), koes(한-스), koru(한-러) num file name 16 ex) rf_c_330676_koen.json -원천 문장 데이터 및 라벨링 번역 데이터 (다국어-한국어)

No Field name Length Meaning a 대분류 2 or 5 dc-rf(다큐교양), md(영화드라마), ot(기타) b 순서 6 언어별 문장 순서로 매긴 번호 c 언어방향 4 enko(영-한), esko(스-한), ruko(러-한) num file name 13 or 16 ex) dc-rf_000002_enko.json md_100930_enko.json ot_050432_enko.json 2. 데이터 구성

분류 언어 카테고리 구축문장수 원천데이터 한국어-다국어 한국어-영어 교양 101,265 다큐 97,407 연예, 공연 101,252 영화, 드라마 50,254 오락, 예능 100,451 인터뷰 50,473 한국어-스페인어 교양 102,058 다큐 99,326 연예, 공연 101,004 영화, 드라마 49,119 오락, 예능 100,229 인터뷰 50,464 한국어-러시아어 교양 101,558 다큐 100,090 연예, 공연 100,214 영화, 드라마 50,182 오락, 예능 99,775 인터뷰 50,453 다국어-한국어 영어-한국어 다큐교양 50,427 영화드라마 50,485 기타 50,498 스페인어-한국어 다큐교양 50,466 영화드라마 50,009 기타 50,453 러시아어-한국어 다큐교양 50,358 영화드라마 50,295 기타 50,036 라벨링데이터 한국어-다국어 한국어-영어 교양 101,265 다큐 97,407 연예, 공연 101,252 영화, 드라마 50,254 오락, 예능 100,451 인터뷰 50,473 한국어-스페인어 교양 102,058 다큐 99,326 연예, 공연 101,004 영화, 드라마 49,119 오락, 예능 100,229 인터뷰 50,464 한국어-러시아어 교양 101,558 다큐 100,090 연예, 공연 100,214 영화, 드라마 50,182 오락, 예능 99,775 인터뷰 50,453 다국어-한국어 영어-한국어 다큐교양 50,427 영화드라마 50,485 기타 50,498 스페인어-한국어 다큐교양 50,466 영화드라마 50,009 기타 50,453 러시아어-한국어 다큐교양 50,358 영화드라마 50,295 기타 50,036 3. 어노테이션 포맷

-번역 말뭉치 라벨 구성요소구분 속성명 타입 필수여부 설명 범위 비고 1 대분류 string Y 대분류 2 중분류 string Y 중분류(방송사) 3 소분류 string N 프로그램명 4 ID string Y 문장 아이디 5 S-Code string Y 원시언어 코드 6 T-Code string Y 도착언어 코드 7 S-Length number Y 원시언어 문장 길이 8 T-Length number Y 도착언어 문장 길이 9 Ratio number Y 원시어 및 도착어 문장 비율 10 특수표현 string Y 특수표현 11 원문 string Y 원시어 문장 12 MT string Y 자동번역문 13 1차수정 string N 번역기 후처리 번역 14 2차수정 string N 번역문 전수 검사 15 최종번역문 string Y 최종 번역문 4) 데이터 예시(영화드라마 분야)

구분 JSON 구조 번역

(한영){

"대분류": "영화드라마“

"중분류": "CJENM“

"소분류": "오늘의 타로맨스“

"ID": "TKCM000140“

"S-Code": "ko-KR“

"T-Code": "en-US"

"S-Length": 21

"T-Length": 72

"Ratio": 0.22371

"특수표현": "N/A“

"원문": "한강 근처 마포대교에서 막걸리 어때요?"

"MT": "How about makgeolli at Mapo Bridge near the Han River?"

"1차수정": "How about makgeolli at Mapo Bridge near the Han River?"

"2차수정": "How about having some makgeolli near Mapo Bridge over the Han River?"

"최종번역문": "How about having some makgeolli near Mapo Bridge over the Han River?“

}번역

(한러)

"대분류": "영화드라마“

"중분류": "CJENM“

"소분류": "오늘의 타로맨스“

"ID": "TKCM000140“

"S-Code": "ko-KR“

"T-Code": "ru"

"S-Length": 21

"T-Length": 72

"Ratio": 0.22371

"특수표현": "N/A“

"원문": "한강 근처 마포대교에서 막걸리 어때요?"

"MT": "Как насчет макколи на мосту Мапо у реки Хан?"

"1차수정": "Как насчет макколи на мосту Маподэгё у реки Хан?"

"2차수정": "Как насчет выпить макколи у моста Маподэгё на реке Ханган?“

"최종번역문": "Как насчет выпить макколи у моста Маподэгё на реке Ханган?"

}번역

(한스){

"대분류": "영화드라마“

"중분류": "CJENM“

"소분류": "오늘의 타로맨스“

"ID": "TKCM000140“

"S-Code": "ko-KR“

"T-Code": "es-ES"

"S-Length": 21

"T-Length": 72

"Ratio": 0.22371

"특수표현": "N/A“

"원문": "한강 근처 마포대교에서 막걸리 어때요?"

"MT": "¿Qué tal makgeolli en el puente Mapo cerca del río Han?"

"1차수정": "¿Qué tal si tomamos makgeolli cerca del puente Mapo por el Río Hangang?"

"2차수정": "N/A“

"최종번역문": "¿Qué tal si tomamos makgeolli cerca del puente Mapo por el Río Hangang?"

} -

데이터셋 구축 담당자

수행기관(주관) : (주)에버트란

수행기관(주관) 책임자명 전화번호 대표이메일 담당업무 이청호 02-797-2105 john@evertran.com 총괄책임 수행기관(참여)

수행기관(참여) 기관명 담당업무 ㈜디엠티렙스 데이터 정제, 가공, 검수 ㈜솔트룩스이노베이션 데이터 가공, 검수 ㈜시스트란 데이터 가공, 검수 ㈜아이시글로벌 데이터 가공, 검수 ㈜온아시아 데이터 가공, 검수 ㈜윤즈정보개발 데이터 정제, 가공, 검수 사이버한국외국어대학교 산학협력단 데이터 가공, 검수 데이터 관련 문의처

데이터 관련 문의처 담당자명 전화번호 이메일 이청호 02-797-2105 john@evertran.com

-

인터넷과 물리적으로 분리된 온라인·오프라인 공간으로 의료 데이터를 포함하여 보안 조치가 요구되는 데이터를 다운로드 없이 접근하고 분석 가능

* 온라인 안심존 : 보안이 보장된 온라인 네트워크를 통해 집, 연구실, 사무실 등 어디서나 접속하여 데이터에 접근하고 분석

* 오프라인 안심존 : 추가적인 보안이 필요한 데이터를 대상으로 지정된 물리적 공간에서만 접속하여 데이터에 접근하고 분석 -

- AI 허브 접속

신청자 - 안심존

사용신청신청자신청서류 제출* - 심사구축기관

- 승인구축기관

- 데이터 분석 활용신청자

- 분석모델반출신청자

- AI 허브 접속

-

1. 기관생명윤리위원회(IRB) 심의 결과 통지서 [IRB 알아보기]

2. 기관생명윤리위원회(IRB) 승인된 연구계획서

3. 신청자 소속 증빙 서류 (재직증명서, 재학증명서, 근로계약서 등 택1)

4. 안심존 이용 신청서 [다운로드]

5. 보안서약서 [다운로드]

※ 상기 신청서 및 첨부 서류를 완비한 후 신청을 진행하셔야 정상적으로 절차가 이루어집니다. -

신청 및 이용관련 문의는 safezone1@aihub.kr 또는 02-525-7708, 7709로 문의

데이터셋 다운로드 승인이 완료 된 후 API 다운로드 서비스를 이용하실 수 있습니다.

API 다운로드 파일은 분할 압축되어 다운로드 됩니다. 분할 압축 해제를 위해서는 분할 압축 파일들의 병합이 필요하며 리눅스 명령어 사용이 필요합니다.

리눅스 OS 계열에서 다운로드 받으시길 권장하며 윈도우에서 파일 다운로드 시 wsl(리눅스용 윈도우 하위 시스템) 설치가 필요합니다.

※ 파일 병합 리눅스 명령어

find "폴더경로" -name "파일명.zip.part*" -print0 | sort -zt'.' -k2V | xargs -0 cat > "파일명.zip"

- 해당 명령어 실행 시, 실행 경로 위치에 병합 압축 파일이 생성됩니다.

- 병합된 파일 용량이 0일 경우, 제대로 병합이 되지 않은 상태이니 "폴더경로"가 제대로 입력되었는지 확인 부탁드립니다.

※ 데이터셋 소개 페이지에서 다운로드 버튼 클릭하여 승인이 필요합니다.