BETA 민간 민원 상담 LLM 사전학습 및 Instruction Tuning 데이터

- 분야한국어

- 유형 텍스트

- 생성 방식LLM

※ 25년 신규 개방되는 데이터로, 데이터 활용성 검토, 이용자 관점의 개선의견 수렴 등을 통해 수정/보완될 수 있으며 최종데이터, 샘플데이터, 산출물 등은 변경될 수 있습니다

-

데이터 변경이력

데이터 변경이력 버전 일자 변경내용 비고 1.0 2025-04-16 데이터 개방 Beta Version 데이터 히스토리

데이터 히스토리 일자 변경내용 비고 2025-04-16 산출물 전체 공개 소개

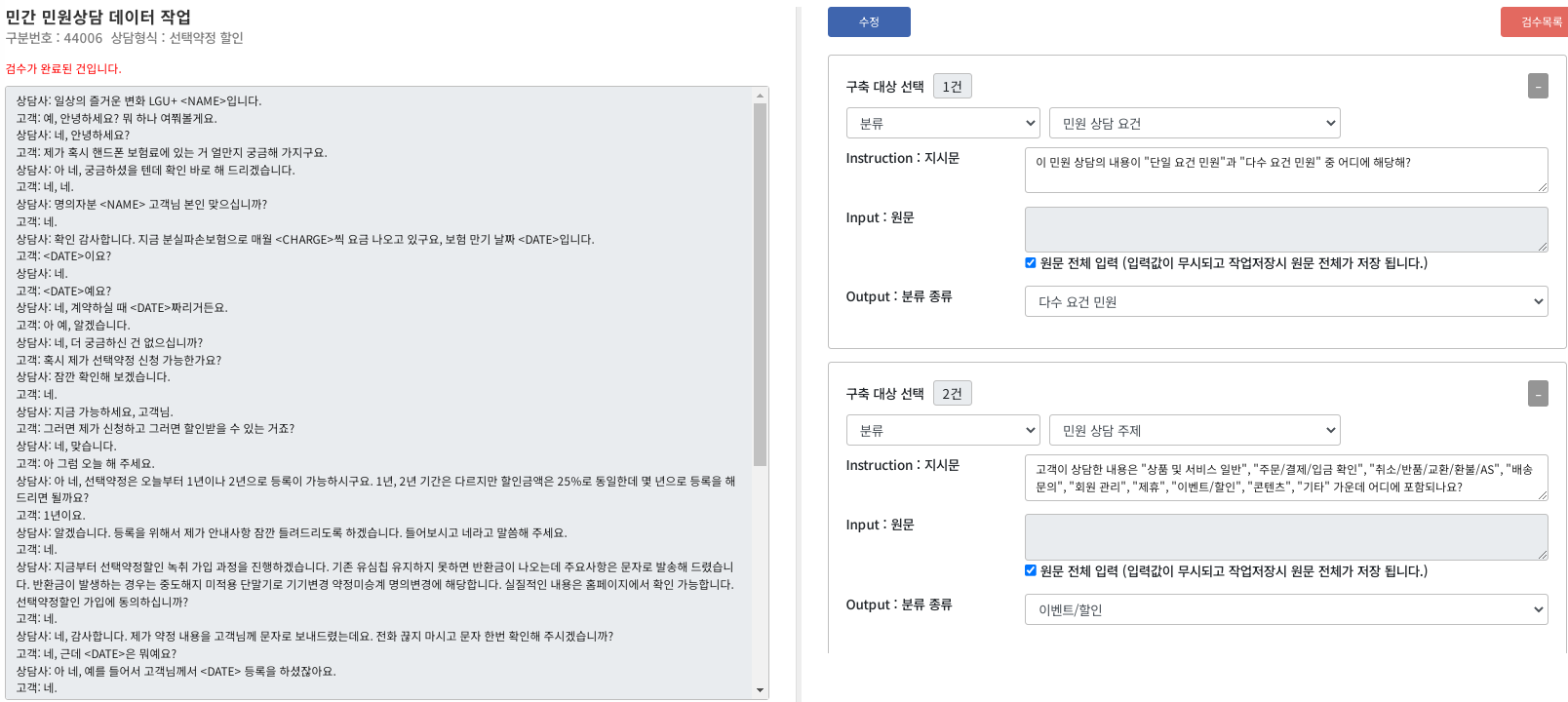

1건당 500글자 이상, 최소 3턴 이상의 질의·답변으로 구성된 민간 민원 상담 텍스트 데이터 1만 건 이상(12,303건)을 수집하여 분류, 요약, 질의응답 유형의 Instruction Tuning Data 구축

구축목적

민간 민원 상담 내용을 기반으로 LLM의 사전학습 및 Instruction Tuning을 위한 가공데이터를 구축하여 민원 상담 분야의 AI 서비스의 품질 제고 및 확산을 위함

-

메타데이터 구조표 데이터 영역 한국어 데이터 유형 텍스트 데이터 형식 json 데이터 출처 하나카드, 엘지유플러스, 액티벤처 라벨링 유형 분류(자연어), 내용요약(자연어), 질의응답(자연어) 라벨링 형식 json 데이터 활용 서비스 챗봇 서비스, AI 상담 도우미 서비스 데이터 구축년도/

데이터 구축량2024년/원천데이터 12,303건, 라벨링 데이터 132,401건 -

총 상담 데이터 건수 12,303건 총 어절 수 총 3,580,857어절 수집 출처 수집처 건수 비율 하나카드 76,804 58.01% 엘지유플러스 43,920 33.17% 액티벤처 11,677 8.82% 합계 132,401 100% 상담데이터 1건당 평균 Instruction tuning data 수 평균 10.76건

(가공데이터 132,401건 / 원천데이터 12,303건)평균 대화턴 수 평균 38.09턴 평균 어절 수 어절 수 분포 건수 비율 124 어절 이하 3 0.02% 125~200 어절 1,819 14.79% 201~250 어절 2,478 20.14% 251~300 어절 2,478 20.14% 301 어절 이상 5,525 44.91% 합계 12,303 100% 수집기관별 업무 유형 분포 하나카드 업무 분야 건수 비율 이용내역 안내 11,034 14.37% 선결제/즉시출금 10,536 13.72% 도난/분실 신청/해제 5,735 7.47% 한도상향 접수/처리 4,728 6.16% 결제대금 안내 3,837 5.00% 승인취소/매출취소 안내 3,584 4.67% 가상 계좌 안내/예약/취소 3,470 4.52% 이벤트 안내 2,493 3.25% 한도 안내 1,875 2.44% 연체대금 즉시출금 ,852 2.41% 결제계좌 안내/변경 1,832 2.39% 일부결제대금이월약정 해지 1,812 2.36% 이용방법 안내 1,807 2.35% 정부지원 바우처 (등유, 임신 등) 1,766 2.30% 결제일 안내/변경/취소 1,678 2.18% 그 외 40건 업무유형 18,765 24.43% 합계 75,804 100% 엘지유플러스 업무 분야 건수 비율 요금 안내 8,428 19.19% 요금 납부 6,360 14.48% 요금제 변경 5,906 13.45% 선택약정 할인 4,630 10.54% 납부 방법 변경 3,944 8.98% 부가서비스 안내 2,549 5.80% 소액 결제 2,283 5.20% 휴대폰 정지/분실/파손 1,958 4.46% 기기변경 1,112 2.53% 명의/번호/유심 해지 1,037 2.36% 그외 50건 업무유형 5713 13.01% 합계 43,920 100% 액티벤처 업무 분야 건수 비율 상품예약 및 결제 6350 54.38% 요금 및 견적 4808 41.17% 일반문의(여행준비, 인터넷, 교통, 안전 등) 261 2.24% 예약변경 및 취소 258 2.21% 합계 11,677 100% 분류 유형 분포 분류 건수 비율 상담 주제 12,323 20.04% 상담 요건 12,303 19.99% 상담 내용 12,303 19.99% 상담 사유 12,303 19.99% 상담 결과 12,303 19.99% 합계 61,535 100% 세부 분류 유형 분포 상담 주제 건수 비율 상품 및 서비스 일반 3,540 28.73% 주문/결제/입금 확인 3,826 31.05% 취소/반품/교환/환불/AS 1,629 13.22% 회원 관리 1,684 13.67% 배송 문의 36 0.29% 이벤트/할인 849 6.89% 콘텐츠 14 0.11% 제휴 619 5.02% 기타 126 1.02% 합계 12,323 100% 상담 요건 건수 비율 단일 요건 민원 10,249 83.30% 다수 요건 민원 2,054 16.70% 합계 12,303 100% 상담 내용 건수 비율 일반 문의 상담 6,083 49.44% 업무 처리 상담 6,191 50.32% 고충 상담 29 0.24% 합계 12,303 100% 상담 사유 건수 비율 업체 425 3.45% 민원인 11,878 96.55% 합계 12,303 100% 상담 결과 건수 비율 만족 9,981 81.12% 미흡 1,025 8.33% 해결 불가 259 2.11% 추가 상담 필요 1,038 8.44% 합계 12,303 100% 요약 유형 분포 요약 유형 건수 비율 기본 요약 12,341 30.76% 길이 제한 요약 10,527 26.24% 주제 중점 요약 8,709 21.71% 핵심 정보 추출 요약 8,538 21.29% 합계 40,115 100% 요약문 길이 분포 요약문 어절 수 분포 건수 비율 5~20 어절 4,800 11.97% 21~40 어절 25,672 64.00% 41~60 어절 6,164 15.36% 61 어절 이상 3,479 8.67% 합계 40,115 100% 질의 유형 분포 질의 유형 건수 비율 의문사형 18,491 60.13% 예/아니요형 12,260 39.87% 합계 30,751 100% 질의 답변 길이 분포 지시(질의)문 건수 비율 1~3 어절 193 0.63% 4~6 어절 11,595 37.71% 7~13 어절 18,569 60.38% 14 어절 이상 394 1.28% 합계 30,751 100% 답변문 건수 비율 1~3 어절 17,456 56.77% 4~6 어절 6,824 22.19% 7~13 어절 6,108 19.86% 14 어절 이상 363 1.18% 합계 30,751 100% 가공 유형 분포 가공 유형 건수 비율 분류 61,535 46.47% 요약 40,115 30.30% 질의응답 30,751 23.23% 합계 132,401 100% -

-

AI 모델 상세 설명서 다운로드

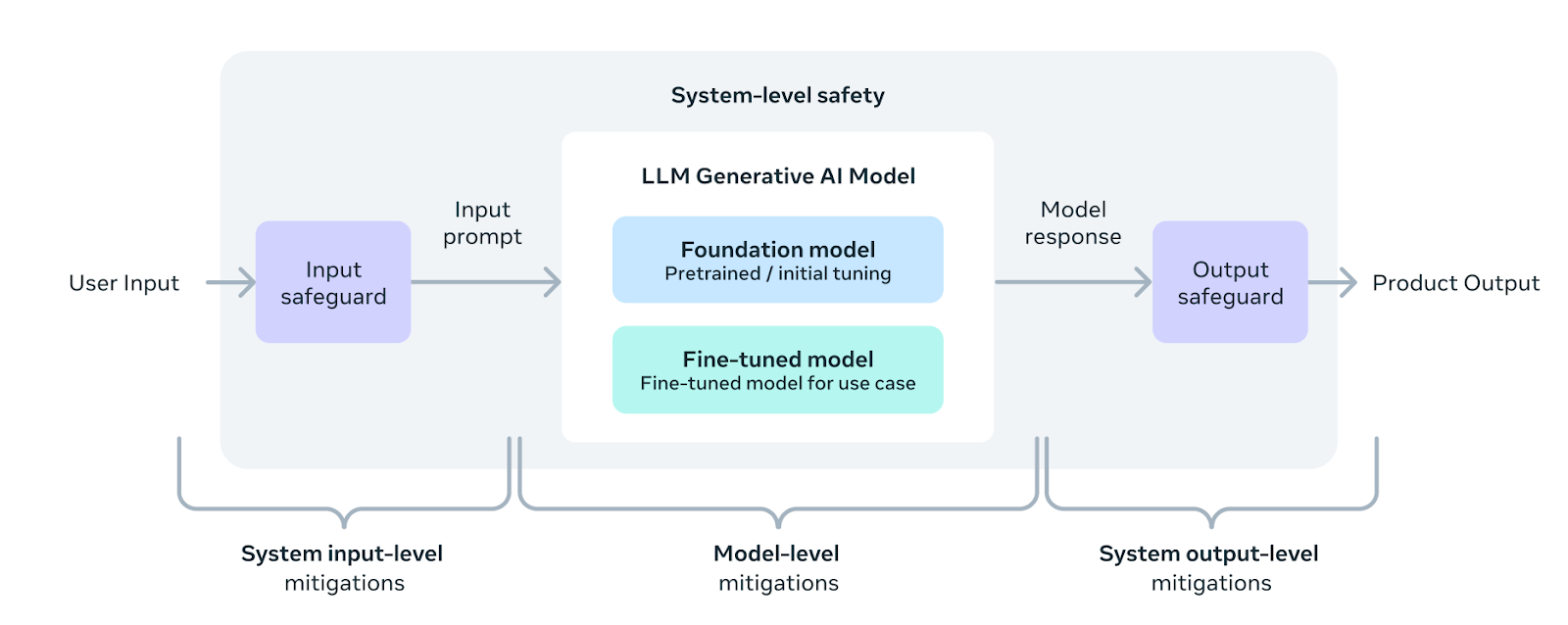

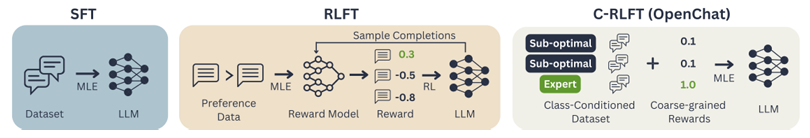

AI 모델 상세 설명서 다운로드 AI 모델 다운로드● 분류 모델 : Meta-Llama-3-8B-Instruct

* LLAMA3 모델은 메타의 AI 그룹이 개발한 차세대 사전 훈련된 대규모 언어 모델(LLM)

* 128K 토큰의 vocabulary 적용

* 사전학습과 강화 학습 과정의 개선을 통해 추론, 코드 생성 및 지시 수행 등의 능력이 기존 모델 대비 대폭 향상

* Groouped Query Attention(GQA)을 통해 추론 효율성 개선

* 파라미터 개수에 따라 다양한 모델 크기를 제공

● 요약 및 질의응답 모델 : openchat-3.5-0106(mistral)

* OpenChat 모델은 C-RLFT 방법론을 사용해 파인튜닝한 오픈 소스 언어 모델

* C-RLFT 방법론은 이미 라벨링된 다양한 품질(고품질과 저품질)의 데이터를 활용하여 클래스 조건화 데이터셋을 구축하고 표준 RLHF 방법론과 유사하게 보상을 최대화하는 방식으로 학습

* OpenChat 최신 모델은 Mistral 과 Gemma을 기본 모델로 한 파인튜닝 모델을 제공

* 최근에 OpenChat-3.5 의 업그레이드 버전이 출시되었으며 다양한 벤치마크에서 뛰어난 성능을 보임. 한국어의 성능도 우수함

-

설명서 및 활용가이드 다운로드

데이터 설명서 다운로드 구축활용가이드 다운로드1. 데이터 구성

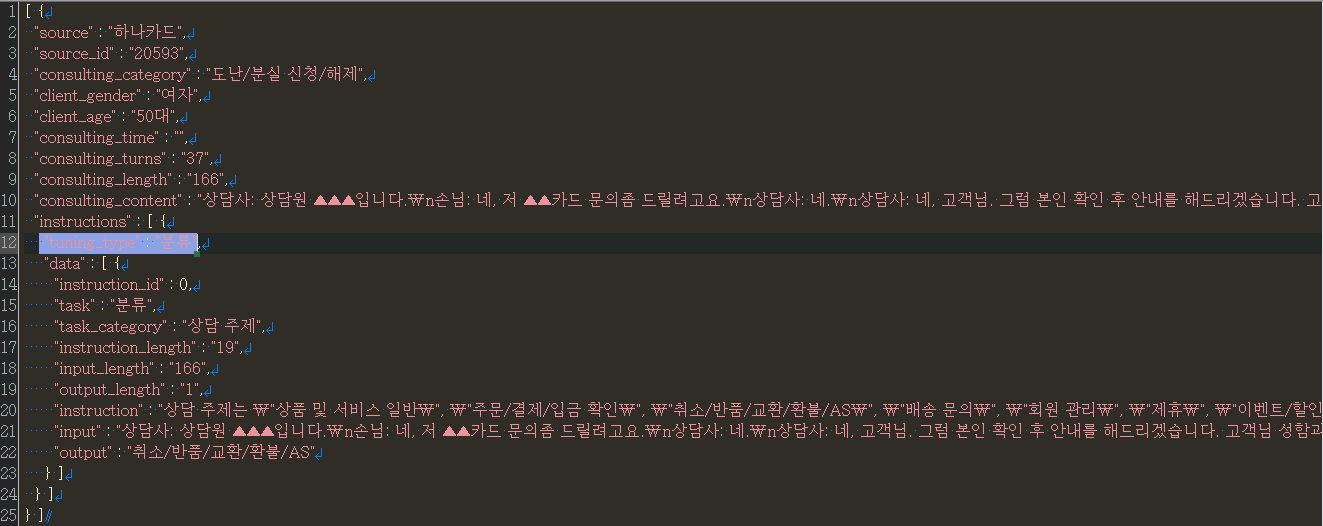

데이터 구성 Key Description Type Child Type source 원천대상 string 수집기관명 source_id 원천데이터 일련번호 string 1 consulting_date 상담일시 string 20231005 consulting_category 수집기관별 업무 유형 string 유형명 client_gender 상담자 유형 string 남, 여 client_age 상담자 연령대 string 30대 consulting_time 상담시간 string 초 consulting_content 상담내용 string consulting_turns 대화턴 수 string consulting_length 상담 내용 길이 string 어절 수 tuning_type 분류, 요약, 질의응답 string instructions.instruction_id 지시문 아이디 number 1, 2, 3... instructions.task 분류, 요약, 질의응답 string instructions.task_category 태스크 하위 카테고리 string 가공 유형명 instruction_length 지시문 길이(어절 수) string input_length input 데이터 길이(어절 수) string output_length output 데이터 길이(어절 수) string instructions.instruction 지시문, 질문 string instructions.input 원천데이터 상담 내용 전체 또는 일부 string instructions.output 분류명, 요약문, 답변 string 2. 어노테이션 포맷

어노테이션 포맷 No 항목명 타입 필수 구분 항목 설명 비고(예시) 1 source string 필수 원천대상 하나카드 2 source_id string 필수 원천데이터 일련번호 1 3 consulting_date string 상담일시 20231005 4 consulting_category string 수집기관별 업무 유형 카드이용 5 client_gender string 상담자 유형 남, 여 6 client_age string 상담자 연령대 30대 7 consulting_time string 상담시간 초 8 consulting_content string 필수 상담내용 9 consulting_turns string 필수 대화턴 수 3턴 이상 10 consulting_length string 필수 상담 내용 길이 125어절 이상 (rfp 500자 이상-1어절 평균 4자 추정) 11 instructions array 1 tuning_type string 필수 분류, 요약, 질의응답 2 data array 1 instructions.instruction_id number 필수 지시문 아이디 "01" 2 instructions.task string 필수 분류, 요약, 질의응답 3 instructions.task_category string 필수 태스크 하위 카테고리 분류 유형, 요약 유형, 질의응답 유형 4 instruction_length string 필수 지시문 길이(어절 수) 5 input_length string 필수 input 데이터 길이(어절 수) 6 output_length string 필수 output 데이터 길이(어절 수) 7 instructions.instruction string 필수 지시문, 질문 8 instructions.input string 필수 원천데이터 상담 내용 전체 또는 일부 9 instructions.output string 필수 분류명, 요약문, 답변 3. 데이터 포맷

4. 실제 예시

-

데이터셋 구축 담당자

수행기관(주관) : 나라지식정보

수행기관(주관) 책임자명 전화번호 대표이메일 담당업무 정규상 02-3141-7644 ksjung@narainformation.com 총괄책임자 수행기관(참여)

수행기관(참여) 기관명 담당업무 디그랩 정제 리스트 수집, 모델링 데이터 관련 문의처

데이터 관련 문의처 담당자명 전화번호 이메일 박분선 02-3141-7644 bspark27@hanmail.net 김희영 02-3141-7644 ahjilu@dgraib.co.kr AI모델 관련 문의처

AI모델 관련 문의처 담당자명 전화번호 이메일 강혁 02-2632-5133 sohohuk@li-st.com 최두 02-2632-5133 codelua@li-st.com 저작도구 관련 문의처

저작도구 관련 문의처 담당자명 전화번호 이메일 강혁 02-2632-5133 sohohuk@li-st.com 최두 02-2632-5133 codelua@li-st.com

-

인터넷과 물리적으로 분리된 온라인·오프라인 공간으로 의료 데이터를 포함하여 보안 조치가 요구되는 데이터를 다운로드 없이 접근하고 분석 가능

* 온라인 안심존 : 보안이 보장된 온라인 네트워크를 통해 집, 연구실, 사무실 등 어디서나 접속하여 데이터에 접근하고 분석

* 오프라인 안심존 : 추가적인 보안이 필요한 데이터를 대상으로 지정된 물리적 공간에서만 접속하여 데이터에 접근하고 분석 -

- AI 허브 접속

신청자 - 안심존

사용신청신청자신청서류 제출* - 심사구축기관

- 승인구축기관

- 데이터 분석 활용신청자

- 분석모델반출신청자

- AI 허브 접속

-

1. 기관생명윤리위원회(IRB) 심의 결과 통지서 [IRB 알아보기] [공용IRB 심의신청 가이드라인]

2. 기관생명윤리위원회(IRB) 승인된 연구계획서

3. 신청자 소속 증빙 서류 (재직증명서, 재학증명서, 근로계약서 등 택1)

4. 안심존 이용 신청서 [다운로드]

5. 보안서약서 [다운로드]

※ 상기 신청서 및 첨부 서류를 완비한 후 신청을 진행하셔야 정상적으로 절차가 이루어집니다. -

신청 및 이용관련 문의는 safezone1@aihub.kr 또는 02-525-7708, 7709로 문의

데이터셋 다운로드 승인이 완료 된 후 API 다운로드 서비스를 이용하실 수 있습니다.

API 다운로드 파일은 분할 압축되어 다운로드 됩니다. 분할 압축 해제를 위해서는 분할 압축 파일들의 병합이 필요하며 리눅스 명령어 사용이 필요합니다.

리눅스 OS 계열에서 다운로드 받으시길 권장하며 윈도우에서 파일 다운로드 시 wsl(리눅스용 윈도우 하위 시스템) 설치가 필요합니다.

※ 파일 병합 리눅스 명령어

find "폴더경로" -name "파일명.zip.part*" -print0 | sort -zt'.' -k2V | xargs -0 cat > "파일명.zip"

- 해당 명령어 실행 시, 실행 경로 위치에 병합 압축 파일이 생성됩니다.

- 병합된 파일 용량이 0일 경우, 제대로 병합이 되지 않은 상태이니 "폴더경로"가 제대로 입력되었는지 확인 부탁드립니다.

※ 데이터셋 소개 페이지에서 다운로드 버튼 클릭하여 승인이 필요합니다.

오프라인 데이터 이용 안내

본 데이터는 K-ICT 빅데이터센터에서도 이용하실 수 있습니다.

다양한 데이터(미개방 데이터 포함)를 분석할 수 있는 오프라인 분석공간을 제공하고 있습니다.

데이터 안심구역 이용절차 및 신청은 K-ICT빅데이터센터 홈페이지를 참고하시기 바랍니다.

국방데이터 개방 안내

본 데이터는 국방데이터로 군사 보안에 따라 AI허브에서 데이터를 제공하지 않으며,

군 담당자를 통한 별도의 사용 신청이 필요합니다.