※ 본 데이터는 추후 개방될 예정입니다. 베타개방을 통해 제공되는 데이터 목록은 공지사항을 참고하시기 바랍니다.

-

데이터 변경이력

데이터 변경이력 버전 일자 변경내용 비고 1.0 2024-06-28 데이터 개방 Beta Version 데이터 히스토리

데이터 히스토리 일자 변경내용 비고 2024-06-28 산출물 공개 Beta Version 소개

- 한국어와 영어 언어쌍에 대한 양방향 병렬 번역 말뭉치 데이터 - 국제 학술대회에서 활용할 수 있는 전문적 분야의 한영/영한 통번역 데이터

구축목적

- 고품질 대규모 학습용 데이터를 구축·개방하여 초거대 AI 환경 조성 - 국제 학술대회용 전문분야 통번역 모델 고도화를 위한 통번역 데이터 구축

-

메타데이터 구조표 데이터 영역 한국어 데이터 유형 오디오 , 텍스트 데이터 형식 WAV, JSON 데이터 출처 국제 학술대회 영상 라벨링 유형 전사(음성)/번역(텍스트) 라벨링 형식 JSON 데이터 활용 서비스 수행기관 자체 음성인식모델 성능 개선, 전문분야 번역 관련 AI 모델 개발 데이터 구축년도/

데이터 구축량2023년/원천데이터 : 총 2,017시간 (900,572 문장) / 라벨링 데이터 : 총 2,017시간 (900,572 문장) -

- 데이터 구축 규모

항목명 지표 규모 구축량 시간/문장수 음성 : 2,017시간 텍스트 : 900,572 문장 언어쌍 분포 시간/문장 한국어 전사 : 1,012 시간 영어 전사 : 1,005 시간 한-영 번역 : 452,764 문장 영-한 번역 : 447,808 문장 주제 분포 비율 인문사회과학: 20% 자연과학 21% 공학: 27% 의약학: 32% - 데이터 분포

데이터 분류 언어 중분류 시간 전사/번역데이터 한국어

(한-영)인문사회과학 201 자연과학 234 공학 203 의약학 374 영어

(영-한)인문사회과학 201 자연과학 201 공학 340 의약학 263 -

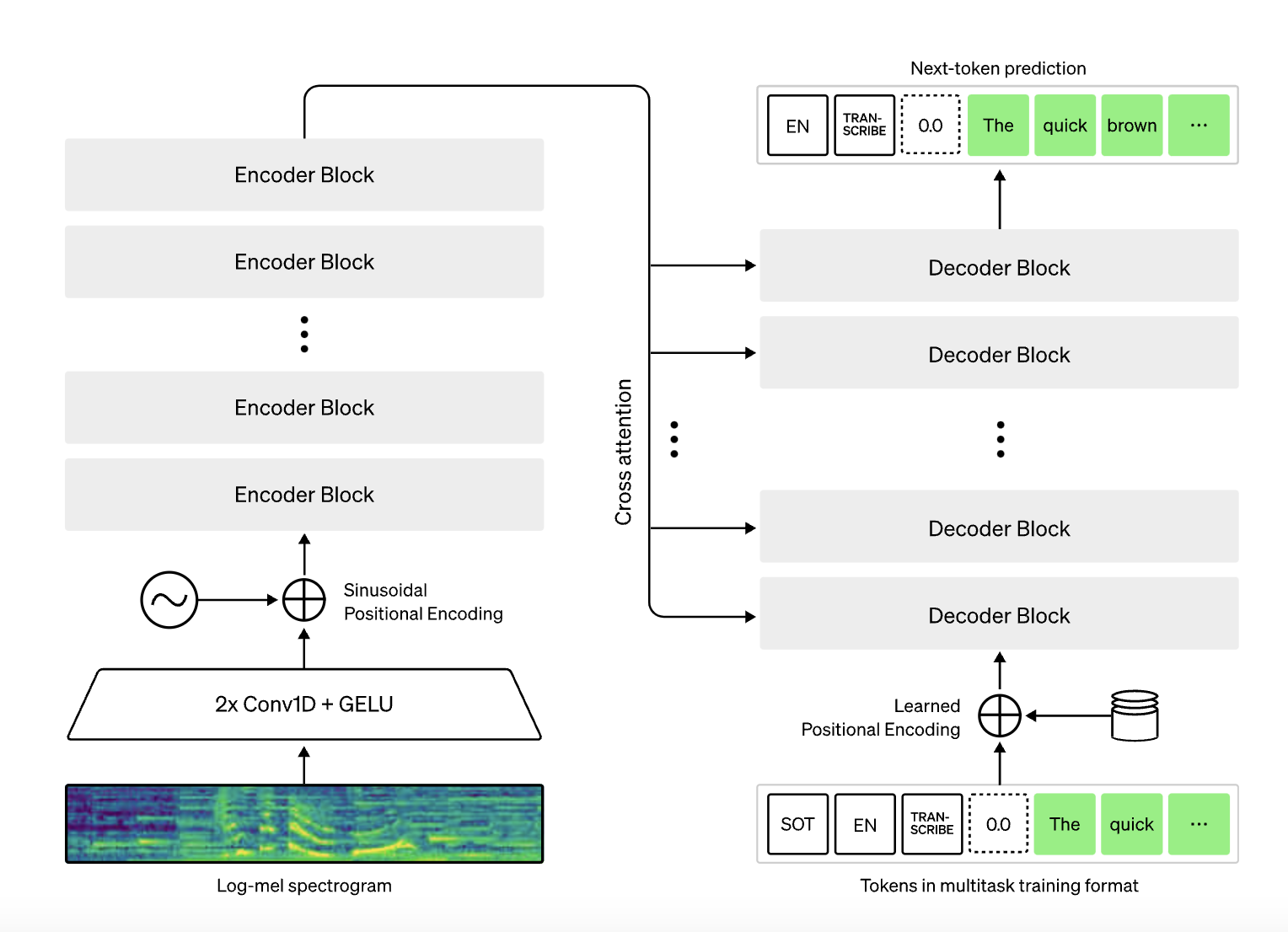

- 전사 모델 : Whisper

- Whisper은 다양한 벤치마크 데이터셋에 대하여 다른 후보 모델이었던 Whisper가 Conformer, Wav2Vec 2.0 모델보다 전반적으로 좋은 성능을 가지고 있으며, 특히 잡음이 많은 음향환경에서 구축된 데이터셋인 Chime-4에 대해서 월등한 성능을 보임

- 한국어 및 영어 각 1,000시간이라는 제한된 데이터만을 학습하여 높은 음성인식 정확도를 달성해야하므로 기학습된 데이터가 가장 많은 Whisper 모델을 기반으로 학습 모델 구현

- Train : 80%, Validation : 10%, Test : 10%

- 학습이 완료된 모델은 추후 한국어와 영어 음성 전사 연구에 활용되거나 말뭉치 연구에 활용할 수 있음. 특히 국제학술대회 데이터로 학습되었기 때문에, 전문 분야 관련 자연어 처리 업무에 활용 가능.

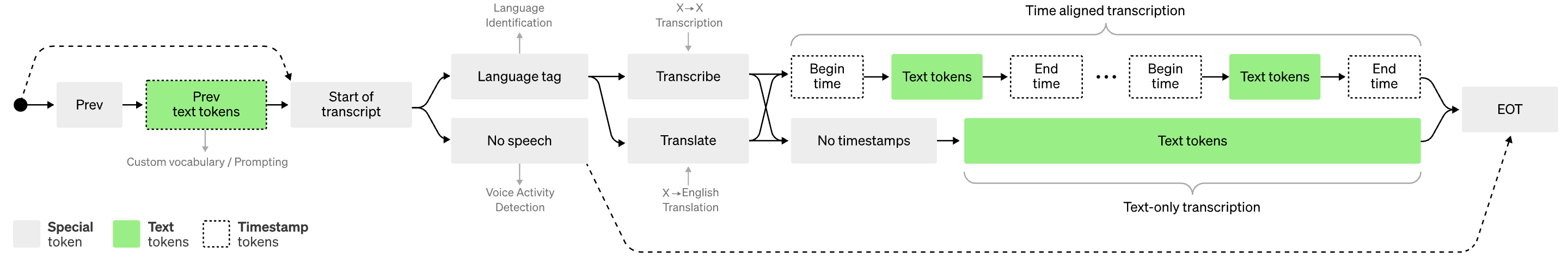

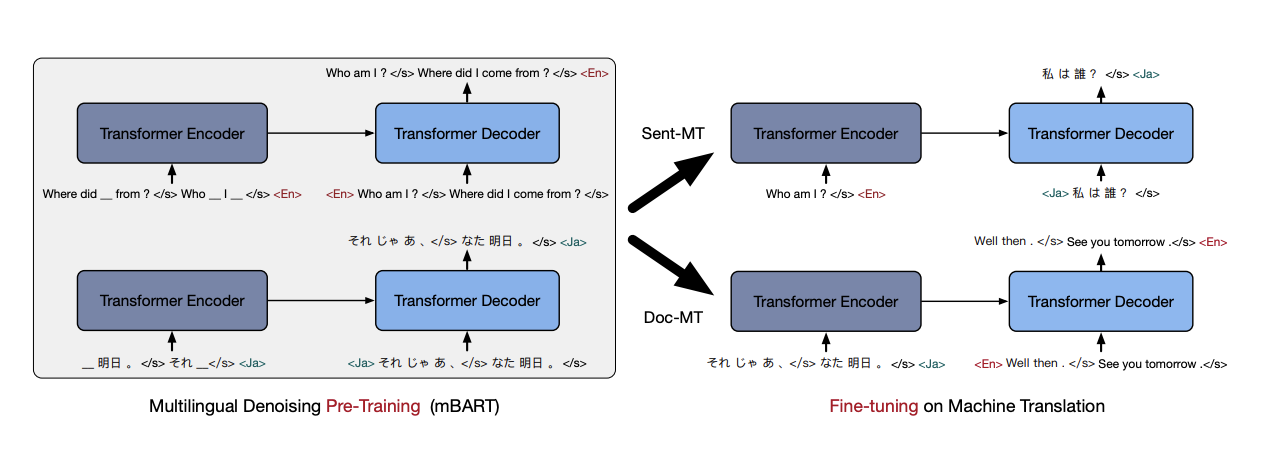

- 번역 모델 : mBART

다국어 트랜스포머 기반 Encoder-Decoder(seq2seq) 구조 모델을 활용한 품질 예측 모델[mBART 학습과 추론]

- mBART는 BART모델에 25개 이상의 언어를 사전학습한 모델로, 다양한 언어 간 번역에 뛰어난 성능 기대 가능

- 또한, mBART 모델은 기학습된 언어 데이터 양이 많으므로 적은 양의 데이터로도 높은 성능 기대 가능

- 제한된 수량의 한국어 및 영어 문장을 학습하여 높은 BLEU 점수를 달성해야하므로 기학습된 번역 데이터가 가장 많은 mBART 모델을 기반으로 학습 모델 구현

- Train : 80%, Validation : 10%, Test : 10%

- 학습이 완료된 해당 모델은 전문 분야 번역 업무에 활용될 수 있음. 전문용어 및 학술용어를 많이 학습을 통해 번역 교정(MTPE) 업무에도 적용 가능 -

- 데이터 구성 및 어노테이션 포맷

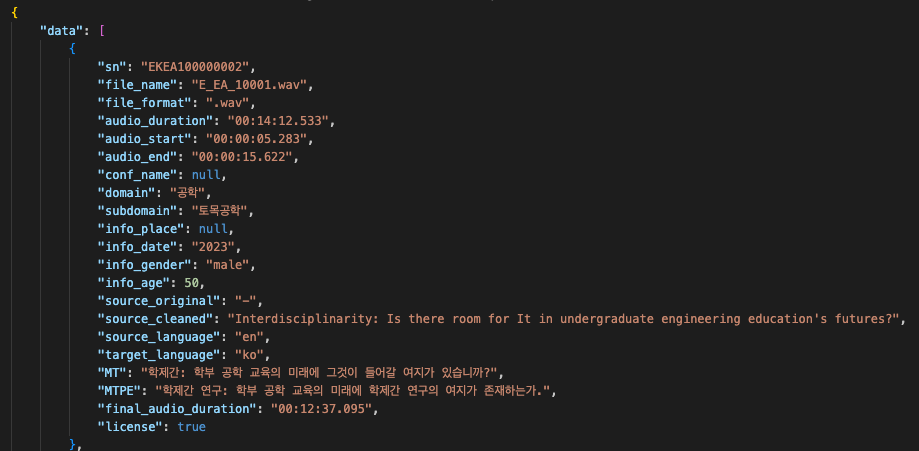

구분 속성명 타입 필수여부 설명 범위 비고 1 data Array Y 데이터 1-1 sn String Y ID 1-2 file_name String Y 원천 데이터 파일명 1-3 file_format String Y 원천 파일 형식 1-4 audio_duration String Y 원시 데이터 음성 길이 0 1-5 audio_start String Y 문장별 발화 시작 시간 0 1-6 audio_end String Y 문장별 발화 종료 시간 0 1-7 conf_name String N 학술대회명 1-8 domain String Y 대분류 1-9 subdomain String N 중분류 1-10 info_place String N 학회명 1-11 info_date String N 학회 주최 년도 YYYY 1-12 info_gender String Y 화자 성별 female, male 1-13 info_age Number Y 화자 연령대 1-14 source_original String Y 전사 원문 1-15 source_cleaned String Y 전사 문장 1-16 source_language String Y 출발 언어 코드 1-17 target_language String Y 도착 언어 코드 1-18 MT String Y 기계 번역문 1-19 MTPE String Y 기계번역 사후교정문 1-20 final_audio_duration String Y 원천 데이터 음성 길이 0 1-21 license Boolean Y 원문의 라이선스 여부 - 데이터 포맷

구분 내용 데이터명 국제 학술대회용 전문분야 한영/영한 통번역 데이터 모델 임무 유형 전사 (한국어, 영어) 및 번역 (한-영, 영-한) 어노테이션 유형 전사, 번역 데이터 원천데이터(WAV)-라벨 데이터(JSON) 구성 데이터 예시 <라벨링 데이터 예시> { "data": [ { "sn": "EKEA100000002", "file_name": "E_EA_10001.wav", "file_format": ".wav", "audio_duration": "00:14:12.533", "audio_start": "00:00:05.283", "audio_end": "00:00:15.622", "conf_name": null, "domain": "공학", "subdomain": "토목공학", "info_place": null, "info_date": "2023", "info_gender": "male", "info_age": 50, "source_original": "-", "source_cleaned": "Interdisciplinarity: Is there room for It in undergraduate engineering education's futures?", "source_language": "en", "target_language": "ko", "MT": "학제간: 학부 공학 교육의 미래에 그것이 들어갈 여지가 있습니까?", "MTPE": "학제간 연구: 학부 공학 교육의 미래에 학제간 연구의 여지가 존재하는가.", "final_audio_duration": "00:12:37.095", "license": true } ] } - JSON 포맷 예시

-

데이터셋 구축 담당자

수행기관(주관) : 트위그팜

수행기관(주관) 책임자명 전화번호 대표이메일 담당업무 백선호 02-1833-5926 ceo@twigfarm.net 사업 총괄 수행기관(참여)

수행기관(참여) 기관명 담당업무 액션파워 AI 모델 개발 및 검증 에퀴코리아 기계번역(한영, 영한), 번역검수(한영, 영한) XL8 기계번역(한영, 영한), 번역검수(한영, 영한) 이포넷 기계번역(한영, 영한), 번역검수(한영, 영한) 인포랑 데이터 획득/수집 캣벨컴퍼니 원문정제 한샘글로벌 기계번역(한영, 영한), 번역검수(한영, 영한) 데이터 관련 문의처

데이터 관련 문의처 담당자명 전화번호 이메일 백선호 02-1833-5926 ceo@twigfarm.net AI모델 관련 문의처

AI모델 관련 문의처 담당자명 전화번호 이메일 백선호 02-1833-5926 ceo@twigfarm.net 저작도구 관련 문의처

저작도구 관련 문의처 담당자명 전화번호 이메일 백선호 02-1833-5926 ceo@twigfarm.net

-

인터넷과 물리적으로 분리된 온라인·오프라인 공간으로 의료 데이터를 포함하여 보안 조치가 요구되는 데이터를 다운로드 없이 접근하고 분석 가능

* 온라인 안심존 : 보안이 보장된 온라인 네트워크를 통해 집, 연구실, 사무실 등 어디서나 접속하여 데이터에 접근하고 분석

* 오프라인 안심존 : 추가적인 보안이 필요한 데이터를 대상으로 지정된 물리적 공간에서만 접속하여 데이터에 접근하고 분석 -

- AI 허브 접속

신청자 - 안심존

사용신청신청자신청서류 제출* - 심사구축기관

- 승인구축기관

- 데이터 분석 활용신청자

- 분석모델반출신청자

- AI 허브 접속

-

1. 기관생명윤리위원회(IRB) 심의 결과 통지서 [IRB 알아보기] [공용IRB 심의신청 가이드라인]

2. 기관생명윤리위원회(IRB) 승인된 연구계획서

3. 신청자 소속 증빙 서류 (재직증명서, 재학증명서, 근로계약서 등 택1)

4. 안심존 이용 신청서 [다운로드]

5. 보안서약서 [다운로드]

※ 상기 신청서 및 첨부 서류를 완비한 후 신청을 진행하셔야 정상적으로 절차가 이루어집니다. -

신청 및 이용관련 문의는 safezone1@aihub.kr 또는 02-525-7708, 7709로 문의

데이터셋 다운로드 승인이 완료 된 후 API 다운로드 서비스를 이용하실 수 있습니다.

API 다운로드 파일은 분할 압축되어 다운로드 됩니다. 분할 압축 해제를 위해서는 분할 압축 파일들의 병합이 필요하며 리눅스 명령어 사용이 필요합니다.

리눅스 OS 계열에서 다운로드 받으시길 권장하며 윈도우에서 파일 다운로드 시 wsl(리눅스용 윈도우 하위 시스템) 설치가 필요합니다.

※ 파일 병합 리눅스 명령어

find "폴더경로" -name "파일명.zip.part*" -print0 | sort -zt'.' -k2V | xargs -0 cat > "파일명.zip"

- 해당 명령어 실행 시, 실행 경로 위치에 병합 압축 파일이 생성됩니다.

- 병합된 파일 용량이 0일 경우, 제대로 병합이 되지 않은 상태이니 "폴더경로"가 제대로 입력되었는지 확인 부탁드립니다.

※ 데이터셋 소개 페이지에서 다운로드 버튼 클릭하여 승인이 필요합니다.